Sora 2: Il Generatore Video AI di OpenAI che Rivoluziona la Creazione di Contenuti Cinematografici

Immagina di poter creare scene cinematografiche professionali semplicemente descrivendo quello che hai in mente. Video con dialoghi perfettamente sincronizzati, movimenti di camera fluidi, effetti drammatici degni di un film hollywoodiano - tutto generato dall'intelligenza artificiale in pochi minuti. Sembra fantascienza? Eppure è esattamente quello che sta succedendo proprio ora con Sora 2 di OpenAI.Se segui il mondo dell'intelligenza artificiale generativa, probabilmente hai sentito parlare di Sora fin dal suo annuncio iniziale. Ma quello che OpenAI ha appena rilasciato va ben oltre le aspettative più ottimistiche. Sora 2 non è semplicemente un aggiornamento incrementale - è un salto quantico nella generazione video con AI che sta già facendo tremare Hollywood e content creator di tutto il mondo.La cosa più sorprendente? Al momento del lancio, puoi testarlo completamente gratis. Non stiamo parlando di una demo limitata con watermark invasivi o restrizioni soffocanti. Parliamo di accesso reale a uno strumento che permette di creare video cinematografici, deepfake (con alcune limitazioni etiche), clip in stile vlog con lip sync quasi perfetto, e scene drammatiche che sembrano estratte da film professionali.Ma andiamo con ordine. Cosa rende Sora 2 così speciale? E soprattutto, come puoi sfruttarlo al massimo per i tuoi progetti creativi o professionali?

Cos'è Sora 2 di OpenAI e Perché Sta Cambiando le Regole del Gioco

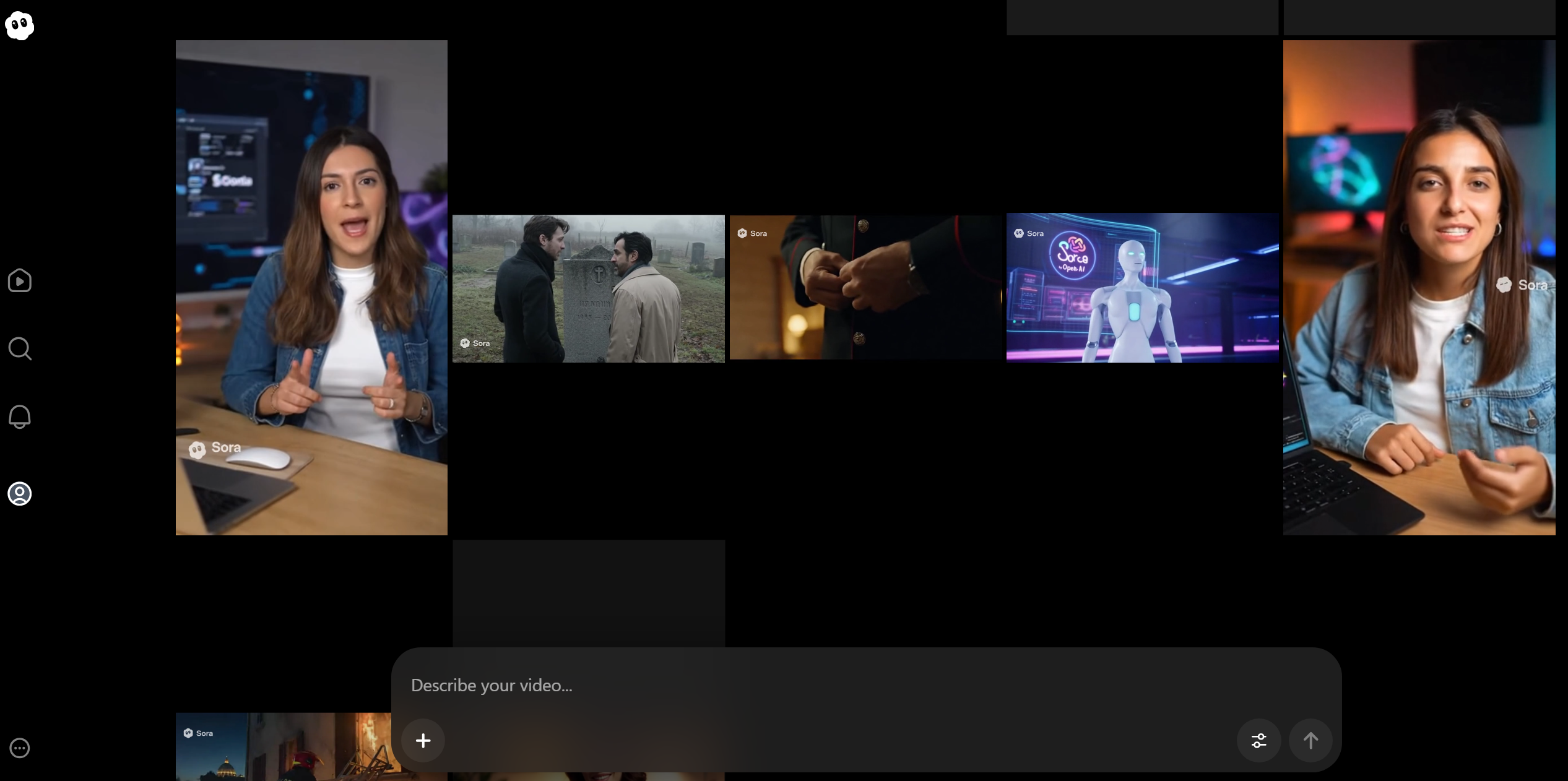

Sora 2 rappresenta l'ultima evoluzione nella generazione video tramite intelligenza artificiale, sviluppata dal team di OpenAI - la stessa azienda dietro ChatGPT e DALL-E. Se la prima versione di Sora aveva già impressionato per la capacità di creare video coerenti da semplici descrizioni testuali, questa seconda iterazione porta il concetto a un livello completamente nuovo.La piattaforma si presenta come un ibrido affascinante: da un lato è un potentissimo generatore video AI, dall'altro funziona come un vero e proprio social network dedicato ai contenuti generati dall'intelligenza artificiale. Puoi creare, condividere, fare remix di video altrui, commentare, seguire altri creator - tutto mentre esplori le infinite possibilità creative offerte dall'AI generativa.Quello che colpisce immediatamente di questo generatore video intelligenza artificiale è la qualità cinematografica dei risultati. Non parliamo di animazioni robotiche o video dall'aspetto artificiale. Stiamo parlando di scene con profondità emotiva, movimenti di camera professionali, illuminazione cinematografica e - aspetto cruciale - lip sync talmente preciso da risultare quasi inquietante.La piattaforma è accessibile tramite il sito ufficiale di OpenAI e, almeno nella fase di lancio, offre possibilità di test gratuite. Certo, essendo in fase beta, ci sono ancora alcune limitazioni tecniche - la risoluzione di output non è ancora in 4K, i server possono essere sovraccarichi nei momenti di picco - ma la direzione è chiara: stiamo assistendo alla democratizzazione della produzione video professionale.Una caratteristica distintiva di Sora 2 è la sua capacità di comprendere prompt in qualsiasi lingua. Puoi scrivere le tue richieste in italiano perfetto, senza bisogno di tradurre in inglese o usare terminologia tecnica complessa. Descrivi la scena che vuoi creare come la racconteresti a un amico, e l'AI la traduce in immagini in movimento.

Accesso e Primi Passi: Come Iniziare a Creare con Sora 2

Per accedere a Sora 2, hai fondamentalmente due strade. La prima è attendere l'accesso pubblico completo, che OpenAI sta gradualmente estendendo. La seconda - quella che molti early adopter stanno usando - è ottenere un codice di invito da qualcuno che ha già accesso alla piattaforma.Il sistema di codici invito non è solo una strategia di marketing. Serve a OpenAI per gestire il carico sui server e raccogliere feedback gradualmente, migliorando il sistema prima del rilascio completo. Se conosci qualcuno che sta già usando Sora 2, può generare codici di invito dal suo account e condividerli con te.Una volta dentro, ti ritroverai di fronte a un'interfaccia che ricorda i social media moderni, ma con superpoteri AI. La home page mostra un feed di video creati dalla community, principalmente in formato portrait 9:16 - quello classico di TikTok e Instagram Reels. Ma non lasciarti ingannare: questa è solo la visualizzazione predefinita.La navigazione è intuitiva: hai sezioni "For You", "Following" e "Top" esattamente come sui social tradizionali. Ma la vera magia inizia quando clicchi sulla barra di creazione. Qui si apre un mondo di possibilità creative che fino a pochi mesi fa richiederebbero team di professionisti e budget considerevoli.L'interfaccia di creazione è volutamente semplice. Al centro hai la barra del prompt dove descrivere cosa vuoi creare. Sulla sinistra, opzioni per caricare un'immagine di partenza (first frame to video). Sulla destra, impostazioni per scegliere il formato del video. Non ci sono centinaia di parametri confusionari - OpenAI ha scelto la semplicità, lasciando che l'intelligenza dell'AI gestisca i dettagli tecnici.Un aspetto fondamentale da comprendere fin da subito: Sora 2 in fase beta è generoso ma non illimitato. Puoi creare moltissimi video per testare le funzionalità, ma durante i picchi di utilizzo potresti incontrare rallentamenti o code di elaborazione. È il prezzo da pagare per un servizio che milioni di persone vogliono provare simultaneamente.

Formati Video e Parametri Disponibili: Le Opzioni Creative di Sora 2

Quando si tratta di creare video con Sora 2, una delle prime domande che sorge spontanea è: quali formati posso utilizzare? La risposta, almeno nella versione beta attuale, è volutamente semplificata per rendere l'esperienza il più fluida possibile.Al momento hai accesso a due formati principali: il portrait 9:16 e il landscape 16:9. Il primo è perfetto per contenuti destinati a piattaforme verticali come TikTok, Instagram Reels, YouTube Shorts. Il secondo è il classico formato orizzontale, ideale per YouTube, contenuti cinematografici, presentazioni professionali.La scelta del formato influenza non solo l'aspetto visivo finale, ma anche come l'AI compone la scena. Un video in formato portrait tenderà ad avere inquadrature più strette, focalizzate sui soggetti. Un landscape permette composizioni più ampie, panorami, scene corali con più elementi in campo.Una limitazione attuale - che probabilmente verrà superata nelle versioni future - è l'impossibilità di scegliere manualmente la risoluzione di output. I video generati hanno una qualità che si attesta attorno ai 360-720p, sufficiente per test e molti utilizzi social, ma non ancora al livello 4K che ci si aspetterebbe per produzioni professionali definitive.Questo però non dovrebbe scoraggiarti. Anche con queste limitazioni tecniche temporanee, la qualità dei movimenti, la coerenza delle scene, il lip sync e la resa cinematografica sono impressionanti. È importante ricordare che stiamo parlando di una versione beta di una tecnologia rivoluzionaria - le migliorie arriveranno rapidamente.Un parametro interessante è la possibilità di caricare un'immagine come primo frame del video. Questa funzione "first frame to video" ti permette di partire da una composizione statica specifica e animarla secondo le tue istruzioni. Vuoi vedere una foto prendere vita? Questa è la funzionalità che fa per te.Importante: al momento Sora 2 non accetta immagini fotorealistiche di persone reali come punto di partenza. Questa è una limitazione etica deliberata per prevenire abusi nella creazione di deepfake non autorizzati. Puoi però usare immagini generate da AI, illustrazioni, o scene senza volti umani riconoscibili.

Creazione Video Cinematografica: Quando l'AI Diventa Regista

Qui arriviamo al cuore pulsante di quello che rende Sora 2 così speciale: la capacità di creare contenuti con una qualità cinematografica che fino a ieri richiedeva troupe professionali, attrezzature costose e competenze specializzate.Immagina di scrivere: "Due vigili del fuoco salvano una donna da un edificio in fiamme, atmosfera drammatica, riprese cinematografiche". Quello che ottieni non è una semplice animazione. È una scena completa con dialoghi sincronizzati perfettamente, espressioni facciali credibili, movimenti di camera dinamici, effetti di luce e ombre realistici.La comprensione del contesto drammatico da parte dell'AI è sorprendente. Se chiedi una scena emotiva - diciamo, due fratelli che si incontrano dopo anni davanti alla tomba del padre - Sora 2 non si limita a posizionare due figure in un cimitero. Crea pause drammatiche nei dialoghi, espressioni cariche di significato, inquadrature che enfatizzano la tensione emotiva.Il lip sync è probabilmente uno degli aspetti più impressionanti. In molte generazioni, il movimento delle labbra corrisponde perfettamente all'audio generato, creando quella sensazione di naturalezza che è sempre stata il tallone d'Achille dei video sintetici. Certo, non è perfetto al 100% in ogni singolo frame, ma il livello raggiunto è già superiore a molte produzioni professionali di qualche anno fa.La gestione delle luci e delle ombre dimostra una comprensione profonda della cinematografia. L'AI sa quando usare il controluce per effetti drammatici, come illuminare un volto per esaltare le emozioni, dove posizionare le fonti di luce per creare profondità. Non sono scelte casuali - riflettono decenni di linguaggio cinematografico assorbito dai dati di training.Particolarmente interessante è come Sora 2 gestisce le scene di gruppo o con più elementi in movimento. La coerenza spaziale - dove ogni oggetto mantiene la sua posizione relativa agli altri attraverso i movimenti di camera - è estremamente difficile da ottenere nella generazione video AI, eppure qui funziona sorprendentemente bene nella maggior parte dei casi.

Deepfake e Personaggi: Le Possibilità Creative (e le Limitazioni Etiche)

Uno degli aspetti che sta generando più discussione è la capacità di Sora 2 di creare video con personaggi famosi, scene ispirate a film cult, o situazioni che coinvolgono figure pubbliche. In sostanza: deepfake creativi.Al momento del lancio beta, Sora 2 permette di creare video che replicano lo stile e l'aspetto di personaggi iconici del cinema. Vuoi vedere Beetlejuice che ordina una pizza bizzarra in un ristorante italiano? Puoi farlo. Desideri una scena in stile Batman vs Spider-Man? È possibile generarla. Questo livello di libertà creativa è senza precedenti in uno strumento così accessibile.Tuttavia, è fondamentale comprendere i confini etici e legali. Sora 2 non permette la creazione di contenuti che potrebbero essere usati per diffamazione, truffe, o situazioni sessualmente esplicite. Le politiche di utilizzo sono chiare: creatività sì, ma con responsabilità.Un esempio concreto di cosa sia possibile: puoi creare un video dove un personaggio stilizzato simile a un attore famoso recita dialoghi originali che tu scrivi. Il risultato può essere incredibilmente convincente - abbastanza da sollevare questioni serie sul futuro della proprietà intellettuale e del diritto d'immagine.La limitazione sull'upload di foto realistiche di persone serve proprio a prevenire gli abusi più evidenti. Non puoi prendere la foto di qualcuno e fargli "dire" qualsiasi cosa. Ma puoi creare personaggi ispirati a figure pubbliche, in contesti chiaramente fantasiosi o parodistici.Questa zona grigia solleva domande affascinanti: quando un video generato dall'AI diventa "troppo convincente"? Dove tracciamo il confine tra satira creativa e falsificazione pericolosa? OpenAI sta navigando questi dilemmi in tempo reale, e probabilmente vedremo le politiche evolversi man mano che la tecnologia matura.Per i content creator, questo significa opportunità enormi per creare contenuti ispirati a universi cinematografici senza violare copyright (finché rimani nel territorio della parodia e del commento critico). Per i filmmaker indipendenti, significa poter visualizzare scene complesse prima di investire in produzioni costose.

Esempio video si Sam Altman che sta Compiendo un Furto: INCREDIBILE

La Funzione Remix: Come Trasformare e Personalizzare Video Esistenti

Una delle feature più innovative di Sora 2 è la funzione Remix, che trasforma la piattaforma da semplice generatore a vero ecosistema creativo collaborativo.Il concetto è brillante nella sua semplicità: vedi un video che ti piace ma vorresti modificarlo? Puoi fare il remix. Non parliamo di semplice riediting o ritaglio - parliamo di reinterpretazione completa attraverso nuovi prompt.Ecco come funziona nella pratica. Apri un video dalla community, clicchi sul pulsante Remix in alto a destra, e ti si apre la barra del prompt. Qui puoi descrivere come vuoi modificare il video originale. "Cambia l'ambientazione da giorno a notte", "Trasforma il personaggio principale in un robot", "Aggiungi effetti di pioggia" - le possibilità sono virtualmente infinite.L'AI prende il video originale come riferimento strutturale - timing, movimenti di camera, composizione generale - e applica le tue modifiche mantenendo la coerenza con la clip di partenza. Il risultato è una variazione che è allo stesso tempo familiare e completamente nuova.Questa funzionalità apre scenari creativi affascinanti. Immagina trend virali dove una singola scena viene remixata in centinaia di varianti dalla community. O filmmaker che collaborano iterando sulle idee altrui, costruendo collettivamente scene sempre più raffinate.Dal punto di vista dell'apprendimento, il Remix è prezioso. Puoi studiare video di alta qualità creati da altri utenti, fare remix con piccole modifiche, e capire come diversi prompt influenzano il risultato finale. È un modo accelerato di padroneggiare l'arte del prompting per video AI.C'è anche un aspetto social interessante: ogni video mostra pubblicamente quanti remix ha generato. I video più "remixabili" tendono a diventare template popolari, creando una sorta di meme culture ma applicata alla generazione video AI.Naturalmente, questo solleva questioni di attribuzione e proprietà creativa. Se fai il remix del video di qualcun altro, di chi è la creazione risultante? OpenAI sta ancora definendo queste dinamiche, e probabilmente vedremo emergere nuove convenzioni sociali attorno alla creatività collaborativa mediata dall'AI.

Video in Stile Vlog e Lip Sync Perfetto: L'AI che Parla

Una delle applicazioni più impressionanti di Sora 2 è la creazione di video in stile vlog con presentatori virtuali che parlano direttamente alla camera. Qui la tecnologia di lip sync - sincronizzazione labiale - raggiunge livelli di perfezione quasi inquietanti.Scrivi un prompt del tipo: "Giovane creator che presenta la nuova versione di Sora AI, stile vlog, entusiasta, parlando direttamente alla camera". Quello che ottieni è un video dove il personaggio generato pronuncia un discorso perfettamente sincronizzato, con espressioni facciali appropriate, gestualità naturale, persino quei micro-movimenti che caratterizzano i parlanti reali.La qualità del lip sync varia leggermente da generazione a generazione - siamo comunque in fase beta - ma nei casi migliori è praticamente indistinguibile da video reali. Le labbra si muovono esattamente come dovrebbero per i suoni prodotti, la mascella si apre e chiude con il ritmo corretto, la lingua è visibile nei momenti appropriati.Questo livello di realismo apre possibilità enormi per content creator. Puoi generare presentatori virtuali per spiegare concetti, fare tutorial, recensioni prodotto, senza mai apparire personalmente davanti alla camera. Per chi soffre di ansia da telecamera o semplicemente preferisce rimanere anonimo, è una rivoluzione.Ma c'è di più. Puoi creare presentatori in lingue che non parli. Vuoi un video in inglese perfetto ma il tuo inglese è incerto? Genera il presentatore che parla fluentemente. Hai bisogno di contenuti in spagnolo, francese, giapponese? L'AI gestisce la pronuncia corretta e il lip sync in qualsiasi lingua.Le applicazioni professionali sono evidenti: video formativi aziendali, presentazioni prodotto per e-commerce, contenuti educativi, annunci pubblicitari. Quello che prima richiedeva attori, troupe, location, può ora essere generato con un prompt ben scritto.Naturalmente, questo potere viene con responsabilità. La capacità di creare presentatori virtuali convincenti solleva questioni etiche importanti. È fondamentale dichiarare quando un video è generato da AI, specialmente in contesti dove potrebbe influenzare decisioni importanti o opinioni pubbliche.

Higgsfield AI: Wan 2.5 Illimitato e Senza Censura per la Generazione Video

Se Sora 2 ti ha impressionato, c'è un altro strumento che merita assolutamente la tua attenzione in questo momento: Higgsfield AI. Questa piattaforma sta facendo parlare di sé per una ragione molto specifica e allettante: al momento offre accesso illimitato e senza censura al modello Wan 2.5, uno dei generatori video AI più potenti attualmente disponibili.Ma facciamo un passo indietro. Cos'è esattamente Higgsfield AI? Si tratta di una piattaforma innovativa dedicata alla generazione di video tramite intelligenza artificiale, che si distingue per la sua filosofia di accessibilità e libertà creativa. A differenza di molti competitor che impongono restrizioni severe o limiti di utilizzo frustranti, Higgsfield ha scelto di aprire le porte alla sperimentazione senza freni.Il vero gioiello della corona è il modello Wan 2.5, che rappresenta una delle iterazioni più avanzate nella generazione video AI. Questo modello eccelle nella creazione di contenuti visivamente coerenti, con movimenti fluidi e una comprensione del contesto che rivaleggia con i migliori tool del settore. La qualità delle animazioni, la gestione della fisica degli oggetti e la capacità di mantenere coerenza stilistica attraverso le scene lo rendono uno strumento professionale di altissimo livello.Ma ecco la parte davvero interessante: modalità illimitata. Mentre altri servizi ti costringono a contare ogni generazione, preoccupandoti di esaurire crediti o quote mensili, Higgsfield AI ti permette di sperimentare liberamente. Vuoi generare decine di varianti della stessa scena per trovare quella perfetta? Vai avanti. Hai bisogno di testare approcci creativi diversi senza preoccuparti dei costi? Nessun problema.L'aspetto senza censura è altrettanto rilevante. Ovviamente, questo non significa che puoi creare contenuti illegali o dannosi - ci sono comunque linee etiche e legali da rispettare. Ma significa che hai maggiore libertà creativa rispetto a piattaforme che impongono filtri eccessivamente restrittivi. Puoi esplorare temi artistici più maturi, creare contenuti edgy per il tuo pubblico adulto, o semplicemente non preoccuparti che il sistema blocchi le tue richieste creative perfettamente legittime.La promozione attuale con Wan 2.5 in modalità illimitata rappresenta un'opportunità incredibile per content creator, filmmaker, marketer e chiunque voglia esplorare seriamente la frontiera della generazione video AI. È il momento perfetto per testare workflow professionali, creare portfolio di contenuti generati da AI, o semplicemente spingersi ai limiti di cosa è possibile con questi strumenti.Higgsfield AI si posiziona come alternativa complementare a strumenti come Sora 2.

Dove Sora eccelle nel realismo fotografico e nelle scene cinematografiche complesse, Higgsfield con Wan 2.5 brilla nella versatilità e nella libertà di sperimentazione. Molti professionisti stanno adottando un approccio "best of both worlds", usando entrambi gli strumenti per diversi tipi di progetti.La piattaforma offre anche un'interfaccia intuitiva che rende la generazione video accessibile anche a chi non ha esperienza tecnica. Non servono competenze di programmazione o conoscenze approfondite di AI - descrivi quello che vuoi creare, e l'intelligenza artificiale fa il resto. Questo democratizza ulteriormente la produzione video professionale, mettendola nelle mani di chiunque abbia una visione creativa.Se stai seriamente considerando di integrare la generazione video AI nel tuo workflow creativo o professionale, questa è un'occasione da non perdere. L'accesso illimitato a un modello così avanzato non è qualcosa che capita spesso, e chi sa quanto durerà questa promozione. Vale decisamente la pena esplorare Higgsfield AI e sperimentare con Wan 2.5 mentre l'opportunità è disponibile.Claude non ha l’accesso a internet abilitato. Attiva la ricerca web per ottenere link precisi e aggiornati.

Limitazioni Attuali e Considerazioni Tecniche di Sora 2

Nonostante l'entusiasmo giustificato, è importante essere onesti sulle limitazioni attuali di Sora 2. Comprendere questi limiti ti aiuterà a utilizzare lo strumento in modo più efficace e ad avere aspettative realistiche.La prima limitazione è la risoluzione di output. Come accennato, i video non sono ancora in Full HD o 4K. La qualità si attesta attorno ai 360-720p, sufficiente per molti utilizzi social e test, ma non ancora professionale per produzioni cinematografiche definitive. OpenAI ha chiaramente in roadmap il miglioramento della risoluzione, ma per ora è un compromesso necessario.La velocità di generazione può essere frustrante nei momenti di picco. Con milioni di utenti che testano simultaneamente la piattaforma, i server sono spesso sotto pressione. Non è raro attendere diversi minuti per la generazione di un video, o addirittura incontrare errori che richiedono di riprovare. Pazienza e persistenza sono virtù necessarie in questa fase beta.La coerenza dei risultati non è perfetta. Lo stesso identico prompt può produrre risultati qualitativamente diversi in generazioni successive. A volte ottieni un capolavoro cinematografico, altre volte qualcosa di mediocre. Questa variabilità è intrinseca ai modelli generativi attuali e richiede un approccio iterativo: genera, valuta, rigenera se necessario.Come menzionato, non puoi caricare foto realistiche di persone reali. Questa è una limitazione etica intenzionale, non tecnica. Se il tuo use case richiede di animare foto specifiche di individui, dovrai cercare alternative o aspettare che OpenAI implementi meccanismi di consenso e verifica.I video generati hanno durata limitata. Non puoi creare lungometraggi o documentari estesi - stiamo parlando di clip che vanno da pochi secondi a un paio di minuti al massimo. Per progetti più lunghi, dovrai generare segmenti multipli e assemblarli con software di editing tradizionali.La comprensione fisica del mondo reale, sebbene impressionante, non è perfetta. Occasionalmente vedrai mani con dita in più o in meno, oggetti che si comportano in modi fisicamente impossibili, transizioni strane tra inquadrature. Questi artefatti sono sempre meno frequenti ma non ancora completamente eliminati.Infine, i costi a lungo termine sono ancora incerti. La versione beta gratuita è un'opportunità fantastica, ma è lecito aspettarsi che quando Sora 2 passerà a commercializzazione completa, ci saranno piani a pagamento. Quanto costeranno? Quali limitazioni avranno gli account gratuiti? Queste domande al momento rimangono senza risposta.

Gestione Account e Funzionalità Social di Sora 2

Sora 2 non è solo un generatore video AI - è anche una piattaforma social completa dove puoi costruire una presenza, interagire con altri creator e far crescere una community attorno ai tuoi contenuti generati.La sezione account è il tuo hub personale. Qui trovi tutte le tue creazioni organizzate in diverse categorie: i post pubblicati, i draft (bozze) ancora in lavorazione, i video che hai messo like, e le interazioni sociali come follower e following. L'interfaccia ricorda quella di Instagram o TikTok, rendendo la navigazione intuitiva anche per chi non ha esperienza con tool AI.La funzione Cameo è particolarmente interessante. Funziona come un sistema di tagging dove puoi menzionare altri utenti nei tuoi video o nei prompt. Questo crea dinamiche collaborative dove più creator possono contribuire a progetti condivisi o rispondere creativamente ai contenuti altrui.Ogni video che pubblichi può ricevere commenti, like, e - come abbiamo visto - può essere remixato da altri utenti. Questo crea un ecosistema virale dove i contenuti migliori emergono naturalmente attraverso l'engagement della community. Se crei qualcosa di particolarmente originale o tecnicamente impressionante, può rapidamente diventare trending sulla piattaforma.La sezione Draft è fondamentale per gestire il tuo workflow creativo. Non tutti i video generati saranno perfetti al primo tentativo. Puoi salvare diverse versioni come bozze, confrontarle, perfezionarle nel tempo prima di decidere cosa pubblicare. Questo ti permette di mantenere uno standard qualitativo alto nei tuoi post pubblici.Un aspetto ancora non completamente chiaro è se ci sono limiti al numero di video che puoi generare. Nella fase beta attuale, molti utenti riportano di poter creare numerosi video senza apparenti restrizioni, ma con l'avvertenza che i server sovraccarichi possono rallentare il processo. È probabile che con il passaggio a un modello commerciale completo, emergeranno tier diversi con quote differenziate.La sezione parental control e privacy settings riflette l'attenzione di OpenAI alle questioni etiche. Puoi controllare chi può vedere i tuoi contenuti, chi può fare remix dei tuoi video, e gestire vari aspetti della tua presenza sulla piattaforma. Essendo integrato con l'ecosistema ChatGPT, molte impostazioni sono condivise tra i diversi prodotti OpenAI.

Applicazioni Pratiche: Come Usare Sora 2 per Progetti Reali

Oltre all'eccitazione tecnologica, la domanda vera è: come posso usare Sora 2 per progetti concreti che generano valore?Per content creator e influencer, le applicazioni sono immediate. Puoi creare intro e outro personalizzati per i tuoi video YouTube senza competenze di motion graphics. Generare b-roll cinematografico per arricchire i tuoi contenuti. Produrre shorts virali per TikTok o Instagram Reels in una frazione del tempo tradizionale.Nel marketing e pubblicità, Sora 2 permette di visualizzare rapidamente concept creativi. Prima di investire budget significativi in produzioni video, puoi generare mockup realistici di spot pubblicitari per testare messaggi, toni, stili visivi. Il costo del fallimento diventa praticamente zero - se un concept non funziona, non hai sprecato nulla oltre a qualche minuto.Per e-commerce e presentazioni prodotto, puoi creare video dimostrativi sofisticati. Un prodotto fisico può essere mostrato in contesti d'uso cinematografici che sarebbe costoso o impossibile filmare realmente. Un software può essere presentato attraverso narrazioni visuali che ne esaltano i benefici.Nell'education, le possibilità sono enormi. Concetti astratti possono essere visualizzati attraverso scenari narrativi coinvolgenti. La storia può prendere vita con ricostruzioni di eventi passati. Lezioni di lingue possono includere dialoghi generati in qualsiasi idioma con pronuncia perfetta.Per filmmaker e sceneggiatori, Sora 2 diventa uno strumento di previsualization rivoluzionario. Puoi "girare" scene complete prima di mettere piede su un set reale, testare inquadrature, ritmo, dialoghi. È come avere un intero studio cinematografico virtuale a disposizione nella fase di pre-produzione.Nel settore della formazione aziendale, video esplicativi e tutorial possono essere generati on-demand per qualsiasi processo o procedura. Nuovi dipendenti possono accedere a materiali formativi visivamente ricchi senza che l'azienda debba investire in costose produzioni video ogni volta che qualcosa cambia.Per artisti e creativi sperimentali, Sora 2 è un nuovo medium espressivo. Puoi creare videoarte, installazioni, performance audiovisive che sarebbe impossibile realizzare con mezzi tradizionali. L'AI diventa collaboratore creativo, non solo strumento.Anche per uso personale le applicazioni sono significative. Vuoi creare un video messaggio speciale per un compleanno? Generare contenuti memorabili per eventi familiari? Dare vita a storie che hai sempre voluto raccontare ma non avevi i mezzi per produrre? Tutto diventa possibile.

Il Futuro della Generazione Video AI: Dove Stiamo Andando

Guardando Sora 2 oggi, è affascinante immaginare dove sarà questa tecnologia tra sei mesi, un anno, cinque anni. I pattern di sviluppo suggeriscono evoluzioni che potrebbero trasformare completamente industrie creative.La risoluzione migliorerà inevitabilmente. Output in 4K e oltre diventeranno standard, rendendo i video generati da AI indistinguibili da produzioni professionali anche sui display più grandi e definiti. Questo eliminerà una delle ultime barriere all'adozione professionale su larga scala.La durata dei video generabili si estenderà. Dai pochi secondi attuali passeremo a minuti, poi a lungometraggi completi. Non è fantascienza - è progressione tecnica inevitabile man mano che modelli e infrastrutture migliorano. Il primo film interamente generato da AI che vince un premio importante è probabilmente a meno di cinque anni di distanza.Il controllo creativo diventerà più sofisticato. Invece di un singolo prompt, avremo la capacità di dirigere scena per scena, specificare movimenti di camera precisi, controllare illuminazione e colore in modo granulare, tutto mantenendo la semplicità d'uso che rende questi strumenti accessibili.L'integrazione con altri media si approfondirà. Immagina workflow dove parti da una sceneggiatura testuale, generi le scene video, aggiungi effetti sonori e musica generata da AI, sincronizzi con voice-over sintetiche o reali - tutto in un ecosistema integrato. La pipeline di produzione diventerà fluida dall'ideazione alla distribuzione.La personalizzazione di massa diventerà realtà. Video marketing personalizzati per ogni singolo utente, contenuti educativi adattati al ritmo di apprendimento individuale, esperienze narrative che si ramificano basandosi sulle scelte dello spettatore. La generazione AI rende scalabili concetti che prima erano economicamente proibitivi.Sul fronte etico e regolatorio, vedremo probabilmente l'emergere di standard di settore, watermarking obbligatorio per contenuti AI, sistemi di verifica per distinguere real da sintetico. La società dovrà adattarsi a un mondo dove "vedere per credere" non è più sufficiente.L'impatto occupazionale sarà significativo ma complesso. Alcune figure professionali dovranno reinventarsi, mentre emergeranno nuovi ruoli: director di AI, prompt engineer specializzati in video, curatori di contenuti sintetici. Come ogni rivoluzione tecnologica, ci saranno disruption ma anche opportunità inedite.

Consigli Pratici per Massimizzare i Risultati con Sora 2

Dopo aver esplorato Sora 2 in profondità, ecco alcuni suggerimenti concreti per ottenere i migliori risultati possibili con questo generatore video AI.Primo: investi tempo nel crafting dei prompt. Sora 2 risponde incredibilmente bene a descrizioni dettagliate e cinematografiche. Non scrivere solo "un gatto che cammina" - scrivi "un gatto soriano che cammina lentamente su un muro di pietra al tramonto, luce dorata, ripresa in slow motion, stile documentario nature". La ricchezza del prompt si traduce direttamente in ricchezza visiva.Secondo: sperimenta con stili e riferimenti cinematografici. Puoi inserire nel prompt riferimenti come "stile Wes Anderson", "illuminazione à la Blade Runner", "movimenti di camera stile Scorsese". L'AI ha assorbito decenni di linguaggio visivo e sa riconoscere e replicare questi stili.Terzo: non fermarti al primo risultato. La natura probabilistica della generazione AI significa che risultati multipli dello stesso prompt possono variare significativamente in qualità. Genera 3-4 versioni, scegli la migliore, poi eventualmente usa quella come base per iterazioni successive.Quarto: usa la funzione Remix strategicamente. Se vedi un video della community che si avvicina a quello che vuoi ma non è esattamente giusto, remixalo invece di partire da zero. È spesso più efficace modificare qualcosa di esistente che creare da zero.Quinto: combina Sora 2 con editing tradizionale. I migliori risultati spesso vengono dall'usare Sora per generare clip individuali, poi assemblarle e rifinirle in software come Premiere Pro o DaVinci Resolve. L'AI gestisce la creazione, tu gestisci la narrazione e il ritmo finale.Sesto: studia i video di successo nella community. Analizza quali prompt hanno generato i risultati più impressionanti, quali pattern emergono, quali tecniche gli altri creator stanno scoprendo. La community è una risorsa di apprendimento collettivo incredibile.Settimo: tieni un archivio dei tuoi prompt migliori. Quando trovi formulazioni che funzionano particolarmente bene, salvale. Costruisci gradualmente una libreria personale di "prompt templates" per diversi tipi di scene, stili, emozioni.Ottavo: sii specifico su aspetti tecnici quando importano. Termini come "shallow depth of field", "dutch angle", "tracking shot", "golden hour lighting" comunicano all'AI esattamente che tipo di resa tecnica desideri.

Scopri di Più sull'AI Generativa e Rimani Sempre Aggiornato

Il mondo dell'intelligenza artificiale generativa sta evolvendo a una velocità vertiginosa. Strumenti come Sora 2 rappresentano solo la punta dell'iceberg di una trasformazione tecnologica che sta ridefinendo creatività, produzione di contenuti e comunicazione visiva.

Se vuoi rimanere al passo con queste innovazioni, scoprire in anteprima i nuovi tool, imparare tecniche avanzate e vedere applicazioni pratiche di questi strumenti rivoluzionari, ti invito caldamente a seguire il canale YouTube AI Universo. Qui troverai tutorial approfonditi, confronti tra strumenti, case study reali e tutto quello che ti serve per padroneggiare l'AI generativa.Non parliamo di teoria astratta o hype tecnologico. Parliamo di guide pratiche, test su campo, risultati concreti che puoi replicare immediatamente nei tuoi progetti. L'intelligenza artificiale non è più il futuro - è il presente, e chi sa padroneggiarla oggi avrà un vantaggio competitivo enorme domani.

Che tu sia un content creator che vuole elevare la qualità dei suoi video, un marketer alla ricerca di nuovi modi per coinvolgere il pubblico, un filmmaker che vuole sperimentare senza limiti di budget, o semplicemente un curioso affascinato dalle possibilità creative dell'AI - c'è un mondo da esplorare, e la comunità di AI Universo è il posto migliore per farlo insieme.