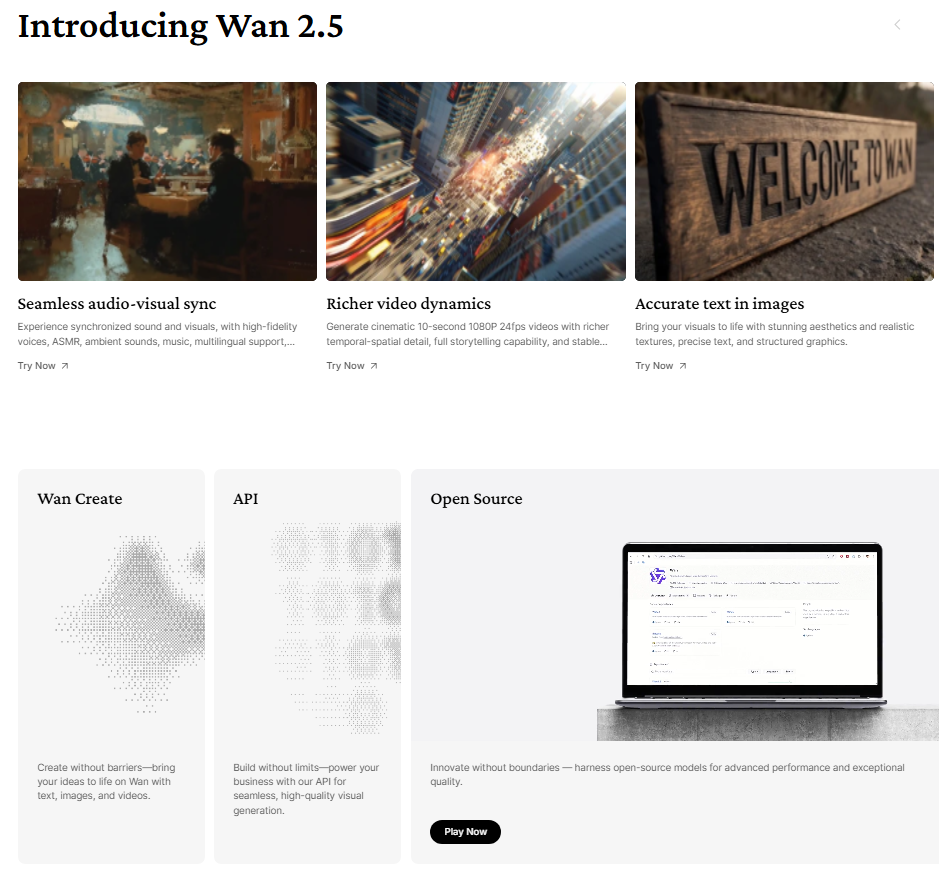

WAN 2.5: Il Generatore Video AI che Sfida Google Veo 3 con Audio e Lipsync Automatici

Se stai cercando il generatore video con intelligenza artificiale che sta facendo tremare anche i colossi come Google, sei nel posto giusto. WAN 2.5 è l'ultimo modello sviluppato dal team cinese che ha già fatto parlare di sé con le versioni precedenti, ma questa volta hanno davvero alzato l'asticella in modo clamoroso. Stiamo parlando di un tool che integra audio automatico con lipsync perfettamente sincronizzato, qualità cinematografica che rivaleggia con Google Veo 3, e una capacità di generare scene complesse con movimento che lascia letteralmente a bocca aperta.La vera rivoluzione di WAN 2.5 non sta solo nella qualità visiva impressionante, ma nell'ecosistema completo che offre: dalla possibilità di testarlo gratuitamente sulla piattaforma ufficiale cinese con crediti giornalieri, all'integrazione premium su Pollo AI che sblocca parametri avanzati e risoluzioni Full HD. Che tu sia un content creator, un filmmaker indipendente o semplicemente un appassionato di tecnologia AI, questo strumento apre possibilità creative che fino a pochi mesi fa sembravano fantascienza.Ma andiamo oltre le solite descrizioni generiche che trovi ovunque. In questo articolo ti mostrerò esattamente cosa rende WAN 2.5 così speciale, con esempi concreti, test pratici su diversi scenari, confronti diretti con la concorrenza e soprattutto guide dettagliate su come ottenere il massimo da questo generatore. Preparati a scoprire il futuro della creazione video con AI.

L'Audio Automatico: La Caratteristica Killer di WAN 2.5

La prima cosa che salta all'occhio quando usi WAN 2.5 è l'integrazione nativa dell'audio con sincronizzazione labiale automatica. Non stiamo parlando di una funzionalità aggiuntiva o di un hack: è parte integrante del modello generativo stesso. Quando scrivi un prompt che include dialoghi, WAN 2.5 genera automaticamente non solo i movimenti delle labbra perfettamente sincronizzati con le parole, ma anche effetti sonori ambientali, soundscape contestuali e persino accenti regionali se specificati nel prompt.Ho testato personalmente questa funzionalità su Pollo AI con decine di clip diverse, e i risultati sono stati costantemente impressionanti. In una scena che ho generato con un soldato italiano che ritorna a casa, il lipsync era così preciso che sembrava quasi impossibile distinguerlo da riprese reali. Le parole "Oh, finalmente sei tornato" e "Mamma, mi dispiace per tutto questo tempo" erano perfettamente sincronizzate con i movimenti facciali del personaggio, completi di microespressioni emotive appropriate.La tecnologia dietro questa funzionalità è particolarmente sofisticata. WAN 2.5 non si limita a muovere la bocca in modo generico mentre riproduce audio: analizza il contenuto fonetico di ogni parola e genera movimenti labiali specifici per ogni suono. Le consonanti labiali come "M", "B" e "P" producono chiusure complete delle labbra. Le vocali aperte come "A" producono aperture appropriate della bocca. Le consonanti dentali coinvolgono la lingua in modo visibile. Questo livello di dettaglio è ciò che rende il risultato così convincente.Ma c'è un aspetto cruciale da considerare: WAN 2.5 performa significativamente meglio con l'inglese rispetto ad altre lingue. Quando ho testato dialoghi in italiano, ho notato che in alcuni casi il modello "si mangia" sillabe o produce sincronizzazioni meno precise. Non è un difetto critico, ma è importante esserne consapevoli. La soluzione? Usare una tecnica di prompt engineering strategica che esploreremo tra poco.Gli effetti sonori ambientali sono un altro punto di forza straordinario. In una scena che ho generato di una coppia al bar, WAN 2.5 ha automaticamente aggiunto il sottofondo di conversazioni distanti, il tintinnio di tazzine, persino il rumore leggero di una macchina del caffè. In una scena d'azione con una motocicletta Vespa, il rombo del motore, il traffico urbano e i suoni della città erano tutti presenti e perfettamente mixati. Questo livello di completezza elimina ore di post-produzione audio.

WAN 2.5 vs Google Veo 3: Il Confronto che Cambia Tutto

Parliamoci chiaro: Google Veo 3 è stato presentato come il nuovo standard d'oro per la generazione video AI. E in effetti, la qualità di Veo 3 è notevole. Ma dopo aver testato approfonditamente entrambi i sistemi, posso dirti con sicurezza che WAN 2.5 non solo tiene testa al gigante di Mountain View, ma in alcune aree specifiche lo supera decisamente.La prima differenza sostanziale riguarda la qualità cinematografica complessiva. Quando generi una scena con WAN 2.5 su Pollo AI, ottieni una resa visiva che sembra davvero estratta da un film professionale. Le inquadrature hanno una composizione naturale, l'illuminazione è drammatica senza essere eccessiva, il movimento di camera è fluido e organico. Ho generato scene di coppie che discutono al bar, soldati in situazioni drammatiche, inseguimenti in Vespa per le strade di Napoli, e ogni volta la resa cinematografica era superiore a quanto ottenuto con Veo 3 in scenari simili.Il movimento complesso è un'altra area dove WAN 2.5 brilla particolarmente. Ho testato scene ad "high motion" - situazioni con tantissimo movimento simultaneo come inseguimenti, azione fisica intensa, scene dinamiche con molteplici elementi in movimento. In una clip che ho generato con la Guardia Costiera italiana su un motoscafo che si schianta tra onde torreggianti durante una tempesta mediterranea, il livello di dettaglio e coerenza fisica era sbalorditivo. L'acqua che schizza, il motoscafo che sobbalza realisticamente, i personaggi che si muovono in modo naturale reagendo alle forze fisiche: tutto perfettamente orchestrato.Google Veo 3 tende a "semplificare" le scene complesse, riducendo il caos visivo per mantenere la coerenza. WAN 2.5, invece, abbraccia la complessità e riesce comunque a mantenere coerenza impressionante. Nelle scene di sfondo, le persone si muovono in modo naturale e indipendente. Gli oggetti reagiscono realisticamente alle interazioni. La fisica degli elementi come acqua, stoffa o capelli è sorprendentemente accurata.L'audio integrato è ovviamente un vantaggio schiacciante per WAN 2.5.

Mentre con Veo 3 devi aggiungere tutto l'audio in post-produzione (dialoghi, effetti sonori, ambiente), con WAN 2.5 su Pollo AI ottieni un video completo e pronto all'uso in un'unica generazione. Questo non solo fa risparmiare tempo: cambia completamente il workflow creativo.La flessibilità dei formati è un altro punto dove WAN 2.5 eccelle. Puoi scegliere nativamente tra 16:9 per contenuti orizzontali tradizionali e 9:16 per contenuti verticali perfetti per TikTok, Reels e Shorts. Con Veo 3 questa flessibilità è molto più limitata, e ottenere formati verticali richiede workaround complessi.Detto questo, Veo 3 ha ancora alcuni vantaggi. La comprensione del linguaggio naturale è leggermente superiore, specialmente per prompt molto complessi o astratti. E ovviamente, essendo Google, l'integrazione con l'ecosistema Google Workspace e altri tool è più fluida. Ma per pura qualità di output video, WAN 2.5 è quanto meno alla pari, e in molti scenari superiore.

Come Testare WAN 2.5 Gratuitamente sulla Piattaforma Ufficiale

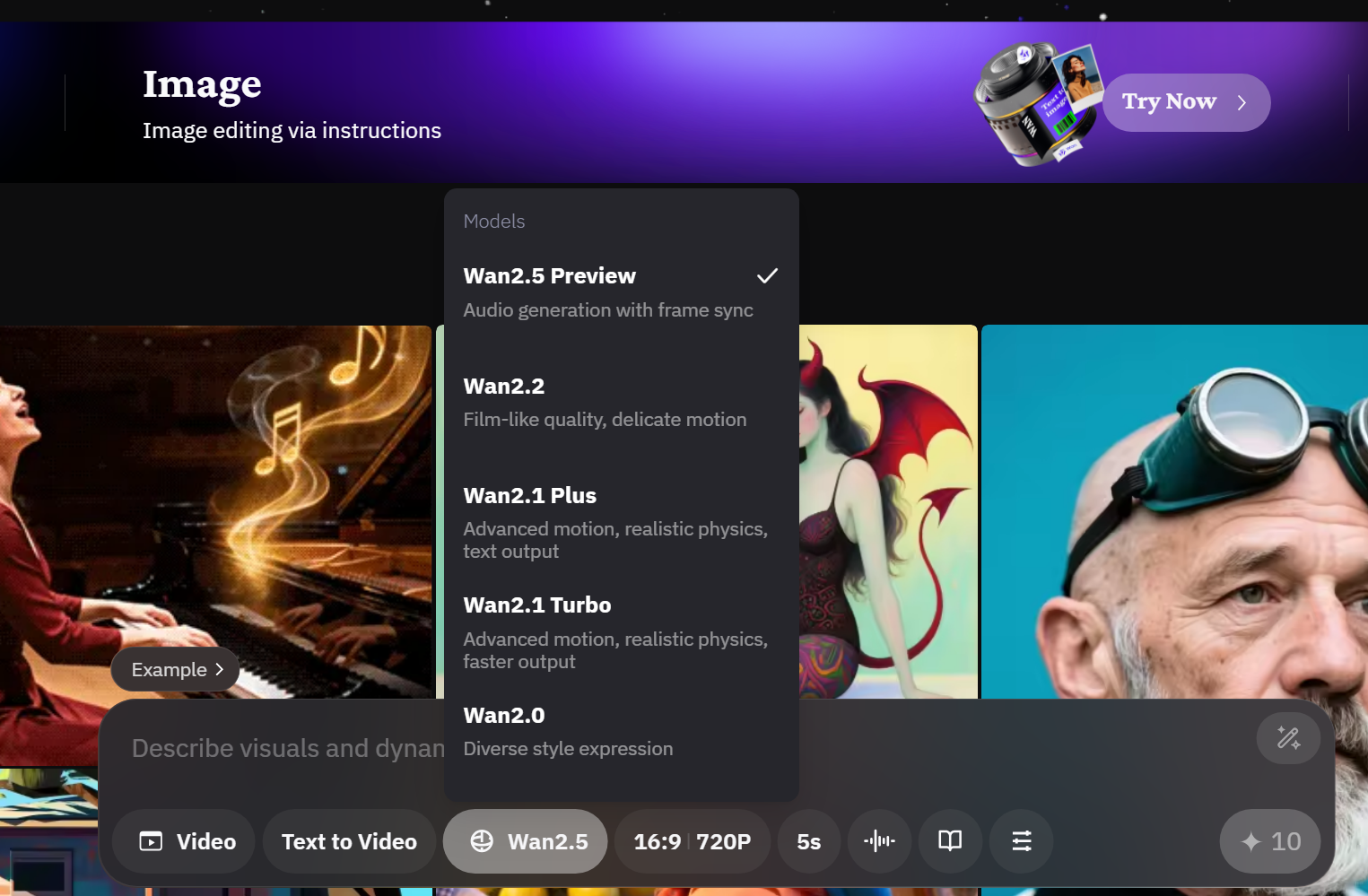

Una delle cose più belle di WAN 2.5 è che puoi iniziare a testarlo completamente gratis sulla piattaforma ufficiale cinese. Il sito si chiama "one.v video" (o più formalmente Tongyi Wanxiang Video Platform), ed è accessibile direttamente dal tuo browser senza bisogno di VPN o altri stratagemmi.Il sistema è elegantemente semplice: ogni giorno puoi fare "check-in" cliccando sul pulsante dedicato nella parte superiore dell'interfaccia, e ricevi automaticamente 10 crediti gratuiti. Con questi crediti puoi generare una clip al giorno in modo completamente gratuito. Non è un trial limitato nel tempo: è un sistema permanente che ti permette di sperimentare con WAN 2.5 senza mai spendere un euro.Per accedere, devi prima creare un account sulla piattaforma. Il processo di registrazione è in cinese, ma con un traduttore automatico del browser (Chrome o Edge lo fanno nativamente) è molto semplice. Tipicamente richiede un numero di telefono per la verifica, ma accetta anche numeri internazionali. Una volta registrato, hai accesso all'intera piattaforma con tutti i suoi strumenti.La gallery della community sulla piattaforma ufficiale è una miniera d'oro di ispirazione. Puoi vedere migliaia di video generati da altri utenti con WAN 2.5, completi dei prompt usati per crearli. Questo è incredibilmente utile per capire quali tipi di prompt funzionano meglio, quali stili sono possibili, e come strutturare le tue richieste per ottenere risultati specifici.I video sulla piattaforma ufficiale sono generalmente in formato standard (presumibilmente 720p o simile) e di durata limitata, ma la qualità è comunque eccellente per sperimentare e imparare. Puoi testare diverse idee, diversi stili di prompt, diverse ambientazioni, tutto senza preoccuparti di budget o limiti stringenti.Un consiglio importante: la piattaforma ufficiale ha occasionalmente tempi di attesa durante i picchi di utilizzo. Se generi durante orari di punta in Cina (sera ora locale cinese), potresti dover aspettare qualche minuto in più. Ma la pazienza viene ripagata con accesso completamente gratuito a uno dei migliori generatori video AI disponibili.Se decidi che WAN 2.5 fa per te e vuoi accedere a funzionalità più avanzate, risoluzioni superiori e tempi di generazione più rapidi, puoi poi passare alla versione premium su Pollo AI, che offre un'esperienza molto più completa e professionale.

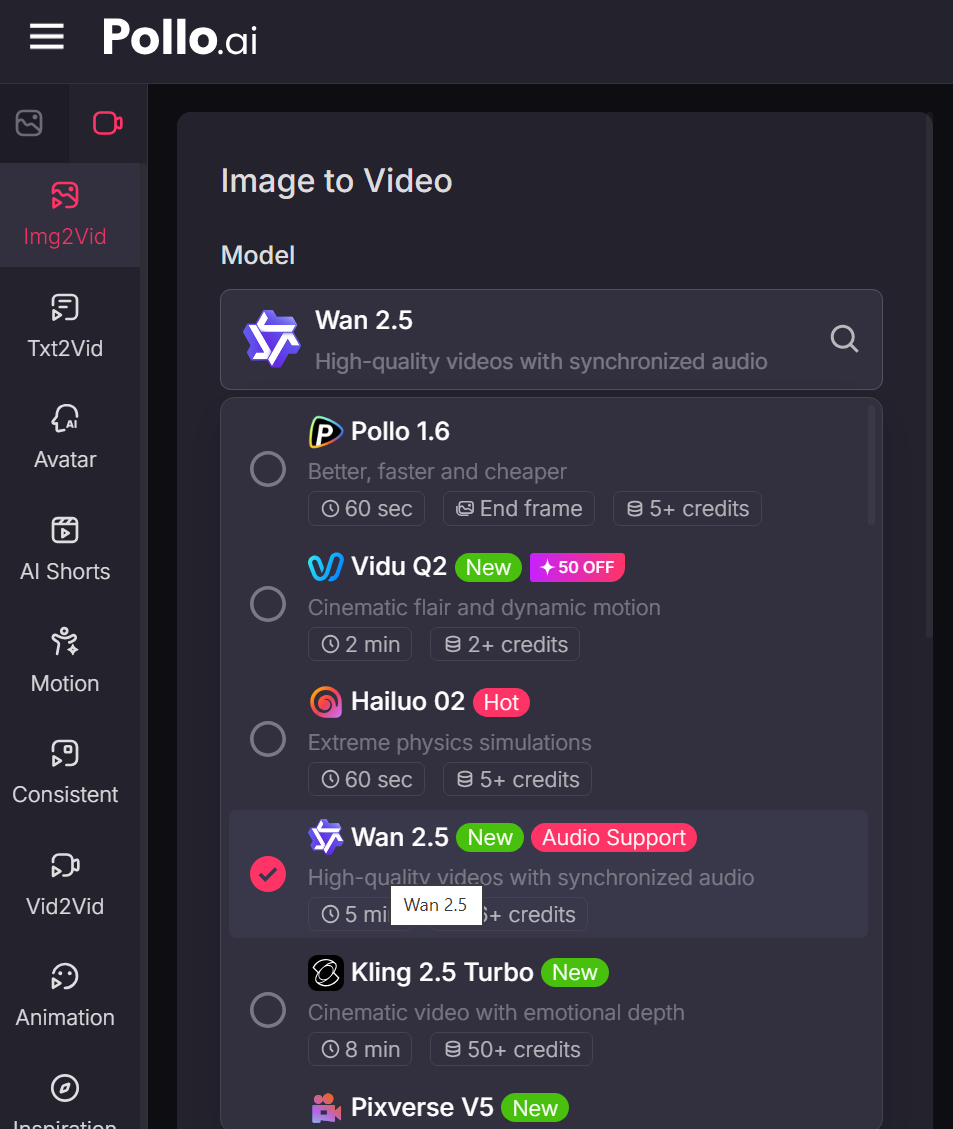

Pollo AI: La Piattaforma Premium per Sfruttare WAN 2.5 al Massimo

Se la piattaforma ufficiale cinese è perfetta per iniziare e sperimentare, Pollo AI è dove WAN 2.5 rivela veramente tutto il suo potenziale. Questa piattaforma integra WAN 2.5 insieme a decine di altri strumenti AI per immagini, video, audio e molto altro, offrendo un ecosistema completo per la creazione di contenuti con intelligenza artificiale.La prima cosa che noti quando usi WAN 2.5 su Pollo AI è l'interfaccia. Mentre la piattaforma cinese ufficiale ha un'interfaccia funzionale ma basic, Pollo AI offre un'esperienza utente raffinata e intuitiva. Tutto è organizzato logicamente, i controlli sono chiari, e l'intero processo dall'idea alla generazione finale è fluido e piacevole.I parametri avanzati disponibili su Pollo AI sono dove la piattaforma mostra veramente il suo valore. Quando selezioni WAN 2.5 come modello generativo, hai accesso a controlli che semplicemente non esistono sulla piattaforma gratuita. Puoi scegliere tra 5 e 10 secondi di durata video. Puoi selezionare la risoluzione: 720p per generazioni più rapide o Full HD 1080p per qualità massima. Puoi decidere se generare audio automaticamente o importare il tuo audio personalizzato.La funzionalità "Auto-generate Audio Track" su Pollo AI è particolarmente potente. Quando la attivi, WAN 2.5 analizza il tuo prompt e genera automaticamente non solo il dialogo specificato con lipsync perfetto, ma anche tutti gli effetti sonori ambientali appropriati alla scena. Una scena al bar avrà automaticamente conversazioni di sottofondo, tazzine che tintinnano, musica d'ambiente. Una scena d'azione avrà esplosioni, passi di corsa, respiri affannati. È magia pura.Ma puoi anche scegliere di importare il tuo audio. Pollo AI supporta file MP3 e WebM, permettendoti di caricare una traccia audio personalizzata che WAN 2.5 userà per generare il video con lipsync sincronizzato. Questo è incredibilmente potente per progetti dove hai già registrato dialoghi specifici o vuoi usare musica particolare.Un'altra caratteristica distintiva di Pollo AI è la possibilità di generare fino a quattro clip contemporaneamente con lo stesso prompt. Questo è fantastico per iterazione creativa: generi quattro variazioni, vedi quale funziona meglio, e procedi da lì. Con WAN 2.5 su questa piattaforma, la sperimentazione diventa veramente efficiente.La risoluzione Full HD 1080p disponibile su Pollo AI fa una differenza enorme per uso professionale. I video in 1080p di WAN 2.5 hanno una nitidezza e un livello di dettaglio che li rende perfettamente utilizzabili per produzioni serie, campagne marketing, contenuti YouTube premium e molto altro. La differenza con il 720p non è drammatica su schermi piccoli, ma su display grandi o per proiezione la qualità superiore è evidente.Pollo AI opera su un sistema di crediti, ma i piani di abbonamento sono strutturati in modo molto ragionevole. Non è gratuito come la piattaforma ufficiale, ma considerando l'accesso a WAN 2.5 con tutti i parametri avanzati più decine di altri tool AI, il valore è eccellente. E per creator che monetizzano i loro contenuti, l'investimento si ripaga rapidamente.

Prompt Engineering per WAN 2.5: La Tecnica dei Dialoghi Italiani

Ora arriviamo alla parte veramente importante: come scrivere prompt efficaci per WAN 2.5 che producano risultati eccellenti, specialmente quando vuoi dialoghi in italiano o altre lingue diverse dall'inglese. Ho sperimentato estensivamente con diverse tecniche e ho trovato un approccio che funziona consistentemente bene.La tecnica fondamentale è questa: scrivi il prompt in inglese, ma inserisci i dialoghi nella lingua che desideri direttamente nel testo. Lasciami spiegare con un esempio concreto. Se vuoi una scena di un soldato italiano che ritorna a casa dalla madre, NON scrivere il prompt tutto in italiano. Invece, strutturalo così:"An Italian soldier in his 30s returns home after a long deployment. He walks through the front door of a modest Italian home. His mother, in her 60s, turns and sees him. She says emotionally: 'Oh, finalmente sei tornato.' He approaches her and replies: 'Mamma, mi dispiace per tutto questo tempo.' Warm afternoon lighting, emotional reunion, cinematic."Vedi la tecnica? La descrizione della scena è in inglese, perché WAN 2.5 comprende meglio l'inglese per quanto riguarda contesto visivo, ambientazione e azione. Ma i dialoghi specifici sono scritti esattamente in italiano, con le parole precise che vuoi sentire nel video finale.Ho testato questa tecnica su Pollo AI con decine di scenari diversi, e i risultati sono stati costantemente superiori rispetto a scrivere tutto in italiano. Il lipsync è più preciso, la comprensione della scena è migliore, e il risultato finale è più cinematografico. È il meglio di entrambi i mondi: la comprensione contestuale dell'inglese combinata con dialoghi perfetti nella lingua desiderata.Un altro trucco importante: usa Claude, ChatGPT o un altro AI assistente per aiutarti a costruire questi prompt ibridi. Puoi dire all'AI: "Crea un prompt in inglese per WAN 2.5 che descrive questa scena [descrivi la scena], ma inserisci questi dialoghi specifici in italiano [scrivi i dialoghi]". L'AI strutturerà il prompt in modo ottimale, assicurandosi che la sintassi sia corretta e che la descrizione sia sufficientemente dettagliata.Per i dialoghi stessi, sii conciso. Ricorda che hai solo 5 o 10 secondi di video, quindi non puoi inserire monologhi lunghi. Una o due frasi brevi per personaggio funzionano perfettamente. Se hai bisogno di più dialogo, considera di dividere la scena in multiple clip separate che poi puoi montare insieme in post-produzione.La specificità è tua amica. Non scrivere genericamente "two people talking". Invece: "A young couple in their 20s sitting at a modern café in Milan, having an intense emotional discussion. She looks at him and says: 'Quindi è davvero questo che vuoi?' He replies regretfully: 'Non ho mai detto che lo volevo, ma è necessario.' Dramatic lighting, close-up shots, relationship drama."Includi dettagli sull'età dei personaggi, l'ambientazione specifica, lo stile visivo desiderato, l'atmosfera emotiva e il tipo di inquadratura che immagini. WAN 2.5 su Pollo AI può interpretare tutti questi dettagli e generare video che matchano sorprendentemente bene la tua visione.Per scene d'azione o "high motion", la tecnica è la stessa ma devi essere ancora più specifico sui movimenti. "Two young Neapolitan men racing through narrow Naples streets on vintage Vespa scooters, weaving through traffic, close pursuit. One yells: 'Luca, ci stanno seguendo!' The other replies: 'Tranquilla, so dove andare!' Fast-paced action, dynamic camera following the Vespas, golden hour lighting."Un ultimo consiglio: salva i tuoi prompt di successo. Quando trovi una formulazione che produce risultati eccellenti con WAN 2.5, conservala in un documento personale. Nel tempo costruirai una libreria di template che puoi modificare e riutilizzare, accelerando drasticamente il tuo workflow creativo.

Text-to-Video: Scene Cinematografiche Che Sembrano Reali

La modalità text-to-video è dove WAN 2.5 su Pollo AI mostra veramente la sua maestria cinematografica. Non stiamo parlando di video che "vanno bene per essere AI": stiamo parlando di clip che potrebbero tranquillamente essere estratte da film o serie TV professionali.Ho generato una scena di una coppia al bar che discute della loro relazione. La composizione dell'inquadratura era perfetta: i personaggi posizionati secondo la regola dei terzi, lo sfondo leggermente sfocato per creare profondità, l'illuminazione naturale che entrava dalle finestre creando un'atmosfera intima. I personaggi di sfondo si muovevano in modo naturale e indipendente, dando vita all'ambiente senza distrarre dai protagonisti.Il dialogo in questa scena era: "Quindi è davvero questo che vuoi?" - "Non ho mai detto che lo volevo, ma è necessario." - "15 anni buttati via." La sincronizzazione labiale era praticamente perfetta, e ciò che mi ha colpito ancora di più erano le microespressioni. Quando il personaggio maschile dice "Non ho mai detto che lo volevo, ma è necessario", la sua espressione mostrava conflitto interno, i suoi occhi si abbassavano leggermente in un momento di disagio. Questi dettagli sottili sono ciò che rende le scene generate da WAN 2.5 così convincenti.Un'altra scena che ho testato su Pollo AI era ad alta intensità d'azione: la Guardia Costiera italiana su un motoscafo durante una tempesta mediterranea al crepuscolo. Questa era una clip di 10 secondi in Full HD 1080p, e il risultato è stato semplicemente spettacolare. Le onde torreggianti, il motoscafo che si schianta violentemente tra i flutti, gli spray d'acqua che schizzano ovunque, il cielo drammatico del crepuscolo: ogni elemento era reso con dettaglio cinematografico.Il dialogo in questa scena era particolarmente complesso: "Ancora un metro, tiralo su!" - "Ce la sto facendo, resisti!" - "No, non ce la faccio più!" - "Forza, sì che ce la fai!" Il lipsync funzionava perfettamente nonostante il movimento caotico della scena, e gli effetti sonori ambientali (onde che si infrangono, vento fortissimo, motore del motoscafo) erano perfettamente mixati con i dialoghi.Ho notato che WAN 2.5 ha una comprensione particolaremente sofisticata di stili cinematografici. Puoi specificare nel prompt "film noir style", "documentary realism", "action movie cinematography", "romantic comedy lighting" e il modello adatta di conseguenza l'estetica visiva. Non è solo una questione di filtri: cambia la composizione dell'inquadratura, il movimento di camera, persino il ritmo della scena.Per scene più tranquille e dialogue-driven, WAN 2.5 su Pollo AI eccelle nel catturare intimità e sottotesto emotivo. Ho generato una scena di due suore italiane che scherzano mentre raccolgono pomodori, e l'atmosfera era così calda e genuina che sembrava documentata dal vero. Le loro espressioni, i piccoli sorrisi, il linguaggio corporeo rilassato: tutto contribuiva a una sensazione di autenticità.Anche le scene più complesse con multipli elementi in movimento vengono gestite sorprendentemente bene. Una scena che ho generato mostrava un uomo sulla trentina che corre disperatamente attraverso un cantiere edile abbandonato nella periferia industriale di Milano al tramonto. La camera lo seguiva con movimento fluido, gli elementi del cantiere erano resi in dettaglio, la luce del tramonto creava drammatici contrasti d'ombra, e il suo respiro affannoso mentre correva era perfettamente sincronizzato con i movimenti del corpo.La coerenza fisica è un altro punto di forza. Gli oggetti non morphano misteriosamente. Le persone non attraversano muri o fluttuano nell'aria. La gravità funziona come dovrebbe. Quando qualcuno cammina, i piedi toccano effettivamente il terreno. Quando qualcosa cade, cade verso il basso. Sembrano dettagli ovvi, ma molti generatori video AI ancora lottano con queste basics fisiche. WAN 2.5 le gestisce naturalmente.

Image-to-Video: Dare Vita alle Tue Immagini Statiche

La modalità image-to-video di WAN 2.5 su Pollo AI è una funzionalità che apre possibilità creative completamente nuove. Invece di partire da zero con un prompt testuale, puoi caricare un'immagine esistente e WAN 2.5 la animerà mantenendo coerenza perfetta con l'estetica e i soggetti dell'immagine originale.Ho testato questa funzionalità creando prima un'immagine realistica con Google ImageFX (usando il modello Imagen 3): una donna e un uomo all'interno di una metropolitana, inquadrati in un momento di conversazione intima. L'immagine era statica ma evocativa, con quella qualità cinematografica tipica dei generatori di immagini AI di ultima generazione.Poi ho caricato questa immagine su Pollo AI nella sezione image-to-video, selezionato WAN 2.5 come modello, e scritto un prompt che specificava un dialogo sull'intelligenza artificiale tra i due personaggi. Il prompt includeva le battute esatte in italiano che volevo sentire, seguendo la tecnica di prompt engineering ibrido inglese-italiano che abbiamo discusso prima.Il risultato è stato sorprendente. I personaggi nell'immagine hanno preso vita mantenendo esattamente le loro caratteristiche fisiche, l'abbigliamento, l'illuminazione e lo stile visivo dell'immagine originale. Non c'è stata quella discontinuità goffa che a volte vedi quando un AI cerca di animare un'immagine statica. Era fluido, naturale, coerente.I movimenti erano sottili ma efficaci: leggere oscillazioni del corpo tipiche di persone che parlano in piedi, movimenti degli occhi che creavano contatto visivo tra i personaggi, espressioni facciali che cambiavano in risposta al dialogo. E ovviamente il lipsync era perfettamente sincronizzato con le parole pronunciate.Un caso d'uso particolarmente potente per l'image-to-video è la creazione di contenuti per social media o marketing. Puoi generare l'immagine perfetta del tuo prodotto con un generatore come Midjourney, DALL-E o Stable Diffusion - ottenendo esattamente la composizione, l'illuminazione e lo stile che desideri - e poi usare WAN 2.5 su Pollo AI per trasformarla in un video dinamico dove qualcuno presenta il prodotto parlando direttamente alla camera.Ho sperimentato con questa tecnica usando diverse immagini generate con vari tool. Un ritratto creato con Midjourney è stato animato con WAN 2.5 per creare un video dove il soggetto si gira verso la camera e pronuncia una battuta. Una scene di prodotto creata con DALL-E è diventata una mini-pubblicità dove l'ambientazione prende vita con movimento sottile e una voiceover sincronizzata.La chiave per ottimi risultati con image-to-video è partire da immagini di alta qualità con composizione chiara. WAN 2.5 funziona meglio quando l'immagine di partenza ha soggetti ben definiti, buona illuminazione e una composizione che "ha senso" anche come singolo frame di un video. Evita immagini troppo stilizzate o astratte dove non è chiaro cosa dovrebbe muoversi e come.Nel prompt per l'image-to-video, descrivi il movimento e l'azione che vuoi vedere, ma non ridescrivere l'immagine stessa. WAN 2.5 può già vedere l'immagine. Concentrati su cosa dovrebbe succedere: "The woman turns to the camera and says...", "The two people begin a conversation...", "The scene comes to life with subtle ambient movement...". Questo focus sull'azione produce risultati migliori rispetto a prompt che ridescrivono ciò che è già visibile nell'immagine.

Parametri Avanzati e Ottimizzazioni su Pollo AI

Quando usi WAN 2.5 su Pollo AI, hai accesso a una serie di parametri e impostazioni che ti permettono di ottimizzare i risultati per le tue specifiche esigenze. Comprendere come usare questi controlli fa la differenza tra risultati buoni e risultati eccezionali.

- Durata Video: Puoi scegliere tra 5 e 10 secondi. La scelta dipende dalla complessità della scena. Per dialoghi semplici o momenti singoli, 5 secondi sono spesso sufficienti e generano più velocemente. Per scene narrative più sviluppate o con dialoghi più lunghi, 10 secondi danno più respiro alla storia. Su Pollo AI, i video da 10 secondi costano più crediti, quindi bilancia qualità desiderata con budget disponibile.

- Risoluzione: 720p è perfetto per contenuti social, bozze rapide e sperimentazione. Genera più velocemente e consuma meno crediti. Full HD 1080p è essenziale per contenuti professionali, presentazioni, o qualsiasi cosa verrà vista su schermi grandi. La differenza di qualità è particolarmente evidente nei dettagli fini: testo leggibile, texture complesse, scene con molta profondità di campo.

- Gestione Audio: L'opzione "Auto-generate Audio Track" è il default e funziona magnificamente per la maggior parte dei casi. WAN 2.5 analizza il prompt e crea automaticamente dialogo con lipsync più effetti ambientali. Ma puoi anche scegliere "Import" per caricare il tuo audio personalizzato (MP3 o WebM supportati), utile se hai già registrato dialoghi specifici o vuoi usare musica particolare. Oppure "None" se vuoi generare solo video silenzioso da sonorizzare completamente in post-produzione.

- Output Video Number: Su Pollo AI puoi generare fino a 4 clip simultaneamente con lo stesso prompt. Questo è incredibilmente utile per iterazione creativa. WAN 2.5 introduce un certo grado di variabilità casuale in ogni generazione, quindi generare multiple versioni ti permette di scegliere quella che meglio corrisponde alla tua visione. Costa più crediti ma fa risparmiare tempo.

- Aspect Ratio: WAN 2.5 su Pollo AI supporta nativamente 16:9 (orizzontale, perfetto per YouTube, presentazioni, TV) e 9:16 (verticale, ideale per TikTok, Reels, Shorts). C'è anche opzione 1:1 (quadrato) per certi tipi di contenuti social. Scegli il formato basandoti su dove distribuirai il contenuto finale.

- Prompt Enhancement: Pollo AI offre un'opzione per far migliorare automaticamente il tuo prompt dall'AI. Se hai scritto un prompt semplice o generico, l'enhancement lo espande aggiungendo dettagli cinematografici, specifiche visive e elementi narrativi. Utile per principianti, ma se hai già scritto un prompt dettagliato e specifico, meglio lasciare l'enhancement disattivato per mantenere il controllo creativo totale.

- Negative Prompt: Nella modalità image-to-video, Pollo AI offre un campo per negative prompt dove puoi specificare cosa NON vuoi vedere nel video. Per esempio: "blurry, distorted faces, unnatural movements, morphing objects". WAN 2.5 cercherà attivamente di evitare questi elementi. Non sempre perfetto ma può aiutare a ridurre artefatti specifici che vuoi evitare.

- Public Visibility e Copy Protection: Opzioni relative alla privacy e protezione dei tuoi contenuti su Pollo AI. Se disattivi public visibility, i tuoi video non appariranno nella gallery pubblica della piattaforma. Copy protection aggiunge watermarking o altre misure per scoraggiare l'uso non autorizzato dei tuoi contenuti da parte di altri utenti della piattaforma.

Un workflow efficiente su Pollo AI con WAN 2.5 è questo: inizia generando multiple variazioni in 720p a 5 secondi per sperimentare e trovare il prompt perfetto. Una volta che hai un risultato che ti soddisfa, rigenera quella specifica versione in 1080p a 10 secondi per la qualità finale. Questo approccio bilancia sperimentazione economica con qualità professionale del risultato finale.

Scene Ad Alta Intensità di Movimento: Test Estremi

Una delle aree più impegnative per qualsiasi generatore video AI è la gestione di scene ad alta intensità di movimento - quello che ho chiamato "high motion" nei miei test. Queste sono scene con azione frenetica, multipli elementi in movimento simultaneo, cambi rapidi di inquadratura o situazioni fisicamente complesse. È qui che molti generatori crollano producendo artefatti, distorsioni o perdita di coerenza.Ho messo WAN 2.5 su Pollo AI alla prova con una serie di scenari estremi appositamente progettati per stressare il sistema. Il primo test era un inseguimento ad alta velocità: due giovani napoletani su Vespa vintage che sfrecciano attraverso le strette strade di Napoli, zigzagando nel traffico, con inseguimento serrato. Movimento rapido, camera dinamica che segue i veicoli, ambientazione urbana complessa.Il risultato è stato... misto ma promettente. La scena catturava l'essenza dell'azione: le Vespa in movimento, l'ambiente urbano, l'energia frenetica dell'inseguimento. Ma con così tanto movimento simultaneo, WAN 2.5 occasionalmente mostrava piccoli artefatti o perdite di dettaglio. Non era brutto, ma non era neanche perfettamente pulito. Il lipsync del dialogo ("Luca, ci stanno seguendo!" - "Tranquilla, so dove andare!") funzionava decentemente considerando il movimento.Il secondo test era ancora più estremo: la Guardia Costiera italiana su un motoscafo che si schianta tra onde torreggianti durante una tempesta mediterranea. Questo combinava movimento violento del veicolo, dinamica complessa dell'acqua, condizioni meteorologiche drammatiche e dialogo contemporaneo. In teoria, un incubo per la maggior parte dei generatori.Sorprendentemente, WAN 2.5 su Pollo AI ha gestito questa scena meglio dell'inseguimento urbano. La fisica dell'acqua era impressionante: onde che si infrangono realisticamente, spray che schizza in modo convincente, il motoscafo che sobbalza e si inclina in risposta alle forze oceaniche. Il dialogo ("Ancora un metro, tiralo su!" - "Ce la sto facendo, resisti!" - "No, non ce la faccio più!") era sincronizzato perfettamente nonostante il movimento caotico.Il terzo test era un uomo sulla trentina che corre disperatamente attraverso un cantiere edile abbandonato, con camera che lo segue in movimento tracking complesso. Questa scena richiedeva coordinazione perfetta tra movimento del soggetto, movimento di camera e renderizzazione dell'ambiente ricco di dettagli.Qui WAN 2.5 ha davvero brillato. La corsa era fluida e naturale, il respiro affannoso del personaggio era sincronizzato con i movimenti corporei, la camera lo seguiva con quel leggermente instabile handheld feel tipico di thriller e found footage, e l'ambiente del cantiere era reso con dettagli convincenti. Il dialogo drammatico ("Non ce la faccio più. Merda.") funzionava perfettamente.Cosa ho imparato da questi test estremi? WAN 2.5 gestisce meglio scene high-motion quando:

- Il movimento ha una direzione chiara e coerente piuttosto che caos multi-direzionale

- C'è un soggetto focale chiaro che la camera può seguire

- Il prompt è specifico sui tipi di movimento desiderati

- L'ambientazione ha elementi riconoscibili che aiutano a mantenere coerenza spaziale

Le scene più difficili sono quelle con troppi elementi indipendenti in movimento simultaneo in direzioni diverse. WAN 2.5 fa un lavoro ammirevole ma non è ancora perfetto in questi scenari estremi. La soluzione è semplificare leggermente il prompt, ridurre il numero di elementi mobili indipendenti, o dividere l'azione complessa in multiple clip più gestibili.

Qualità Full HD: Vale la Pena l'Investimento?

Una domanda che molti si pongono quando usano WAN 2.5 su Pollo AI è se vale veramente la pena spendere crediti extra per la risoluzione Full HD 1080p rispetto al 720p standard. Ho generato decine di scene identiche in entrambe le risoluzioni per fare un confronto diretto e approfondito.La differenza più evidente è nella nitidezza complessiva. Il 1080p ha semplicemente più pixel (1920x1080 vs 1280x720), quindi ogni elemento della scena è renderizzato con maggior dettaglio. Questo è particolarmente importante per:Testo e Scritte: Se la tua scena include testo - cartelli, schermi, libri, qualsiasi cosa con parole - il 1080p rende il testo molto più leggibile. Nel 720p, testo piccolo diventa spesso illeggibile o pixelato. Nel test della Guardia Costiera, per esempio, le scritte sulla tuta dei soccorritori erano chiaramente leggibili in 1080p ma sfocate in 720p.Dettagli Facciali: Le espressioni sottili, le texture della pelle, i piccoli movimenti oculari - tutti questi micro-dettagli che rendono i personaggi convincenti - sono significativamente più evidenti in 1080p. Per scene dialogue-driven dove l'emozione dei personaggi è centrale, questa differenza è sostanziale.Profondità e Texture: Ambienti complessi con molti dettagli - come il cantiere edile abbandonato o la scena della metropolitana - beneficiano enormemente della risoluzione superiore. Texture di muri, pavimenti, oggetti di scena: tutto acquista una ricchezza visiva che il 720p semplicemente non può catturare.Bokeh e Profondità di Campo: Gli effetti di sfocatura dello sfondo (bokeh) che WAN 2.5 usa per creare profondità cinematografica sono più smooth e professionali in 1080p. Nel 720p possono apparire leggermente steppy o artificiali.Detto questo, ci sono situazioni dove il 720p è perfettamente adeguato:

- Contenuti Social Mobile-First: Se stai creando contenuti per TikTok, Reels o Shorts che verranno visti principalmente su smartphone, il 720p è assolutamente sufficiente. Gli schermi piccoli e la compressione delle piattaforme rendono la differenza con 1080p quasi impercettibile.

- Sperimentazione e Iterazione: Quando stai testando idee, provando prompt diversi, cercando l'inquadratura perfetta, ha senso usare 720p per velocità e economia. Genera multiple versioni economiche, trova quella perfetta, poi rifalla in 1080p.

- Clip di Riempimento: Per B-roll, transizioni veloci, o clip che appariranno sullo schermo solo per pochi secondi, il 720p funziona perfettamente bene senza giustificare il costo extra del 1080p.

Il mio consiglio pratico: usa il 720p per il 70-80% del tuo workflow su Pollo AI con WAN 2.5 - sperimentazione, test, iterazione, clip secondarie. Riserva il 1080p per contenuti finali, hero shots, scene emozionalmente cruciali, o qualsiasi cosa che verrà vista su schermi grandi o che richiede dettaglio massimo.Una strategia intelligente è generare in 720p, scaricare la preview, valutare se la clip merita il 1080p, e solo allora rigenerare in alta risoluzione. Questo workflow ottimizza il rapporto qualità/crediti consumati.

Limitazioni Linguistiche e Come Aggirarle

Come abbiamo accennato più volte, WAN 2.5 ha una comprensione significativamente superiore dell'inglese rispetto ad altre lingue, italiano incluso. Questo non è un difetto unico di questo modello - praticamente tutti i generatori AI mostrano bias verso l'inglese semplicemente perché la maggior parte dei dati di training sono in quella lingua. Ma è importante capire esattamente quali sono le limitazioni e come mitigarle.

Il Problema del Lipsync Imperfetto: Quando usi dialoghi completamente in italiano senza la tecnica del prompt ibrido, WAN 2.5 può produrre sincronizzazione labiale imprecisa. A volte "si mangia" sillabe, altre volte la bocca si muove ma le parole sembrano sfasate di una frazione di secondo. In alcuni casi, intere parole possono essere pronunciate in modo poco chiaro o con articolazione strana.Ho notato questo problema particolarmente in scene con dialoghi complessi o veloci. Nella scena delle due suore che parlano di intelligenza artificiale mentre raccolgono pomodori, per esempio, alcune frasi sono uscite con pronuncia strana o con parole "mangiate". Non rendeva il video inutilizzabile, ma certamente era evidente che qualcosa non andava perfettamente.

La Soluzione: Prompt Engineering Ibrido: Come abbiamo discusso estensivamente, la tecnica più efficace è scrivere il prompt principale in inglese ma inserire i dialoghi esatti nella lingua desiderata. Questa approccio sfrutta la migliore comprensione contestuale dell'inglese mentre mantiene i dialoghi nella lingua target.

Semplificare i Dialoghi: Quando lavori in italiano o altre lingue non-inglesi, dialoghi più semplici e pronunciati lentamente tendono a funzionare meglio. Evita frasi troppo complesse, gerghi regionali molto specifici, o dialoghi super veloci. WAN 2.5 su Pollo AI gestisce meglio "Ciao, come stai?" rispetto a una frase lunga e complessa con costruzione grammaticale elaborata.

Iterazione è Fondamentale: A differenza dell'inglese dove il primo tentativo produce spesso risultati eccellenti, con l'italiano o altre lingue potresti aver bisogno di generare 2-3 versioni prima di ottenere una dove il lipsync è soddisfacente. Su Pollo AI puoi generare fino a 4 clip contemporaneamente, il che accelera questo processo di iterazione.

Dialetti Regionali Sono Complicati: Ho testato prompts con dialetti italiani specifici (napoletano, milanese, romano) e i risultati erano molto variabili. WAN 2.5 a volte interpretava correttamente l'accento regionale, altre volte produceva una sorta di "italiano neutro" o addirittura suoni strani che non erano né italiano standard né dialetto riconoscibile. Se l'accento regionale è cruciale per il tuo progetto, sii preparato a molte iterazioni.

Musicalità della Lingua: Lingue con prosodia e ritmo molto diversi dall'inglese (italiano, spagnolo, francese con le loro cadenze melodiche) possono confondere leggermente WAN 2.5. L'intonazione delle frasi potrebbe non essere perfettamente naturale, anche se il lipsync tecnico è corretto.

Alternative Strategiche: Per progetti dove l'italiano perfetto è assolutamente critico, considera questi approcci:

- Genera il video con dialogo inglese usando WAN 2.5, poi sostituisci completamente l'audio in post-produzione con voci italiane registrate professionalmente

- Usa WAN 2.5 per scene senza dialogo o con dialogo minimo, e riserva scene dialogue-heavy per riprese reali o tecniche ibride

- Genera con audio inglese, usa come riferimento/storyboard, poi ricrea con attori reali per la versione finale

Prospettive Future: La buona notizia è che questo è un problema temporaneo. Ogni nuova iterazione di modelli come WAN 2.5 migliora il supporto multi-lingue. È probabile che entro 6-12 mesi vedremo aggiornamenti che gestiscono italiano e altre lingue con la stessa naturalezza dell'inglese. Nel frattempo, la tecnica del prompt ibrido offre un compromesso efficace.

Casi d'Uso Professionali e Creativi

WAN 2.5 su Pollo AI non è solo un giocattolo tecnologico: è uno strumento professionale che può generare valore economico reale in molteplici settori. Esploriamo applicazioni concrete dove questo generatore video AI può fare davvero la differenza.

- Content Creation per YouTube e Social Media: Creator possono usare WAN 2.5 per generare B-roll cinematografico, scene narrative per storytelling, intro e outro personalizzate, transizioni creative tra segmenti. Invece di usare stock footage generico che tutti riconoscono, puoi creare clip uniche perfettamente allineate con la tua narrativa specifica. Un travel YouTuber potrebbe generare scene di destinazioni esotiche senza viaggiare fisicamente. Un educational creator potrebbe visualizzare concetti astratti con scene personalizzate.

- Marketing e Pubblicità Digitale: Agenzie e marketer possono creare rapidamente variazioni di video ads per A/B testing. Genera 10 diverse versioni di uno spot pubblicitario con angolazioni creative diverse, testa quali performano meglio, poi investi nella produzione professionale solo per i concept vincenti. Per piccole imprese con budget limitati, WAN 2.5 permette di creare contenuti video professionali impossibili da permettersi con produzioni tradizionali.

- Pre-visualizzazione Cinematografica: Filmmaker e registi possono usare WAN 2.5 su Pollo AI per creare animatic avanzati o previz di scene complesse. Invece di storyboard statici, genera video che mostrano esattamente come funzionerebbe una scena, completa di movimento di camera, timing, e atmosfera. Questo permette di identificare problemi narrativi o tecnici in pre-produzione quando risolverli è ancora economico.

- E-commerce e Presentazione Prodotti: Genera video dimostrativi di prodotti usando image-to-video. Parti da una bella foto del prodotto, anima con WAN 2.5 per mostrare features o benefici, aggiungi voiceover con le specifiche. Molto più engaging di foto statiche ma frazione del costo di un shooting video professionale. Perfetto per landing pages, ads Facebook/Instagram, e Amazon listings.

- Educazione e Training: Insegnanti possono creare visualizzazioni di concetti complessi, simulazioni di eventi storici, o dimostrazioni di processi scientifici. Una lezione sulla Rivoluzione Francese potrebbe includere scene generate di momenti chiave. Una lezione di fisica potrebbe visualizzare esperimenti pericolosi o impossibili da fare in aula. WAN 2.5 rende l'apprendimento più coinvolgente e accessibile.

- Prototyping per Game Dev: Developer possono generare concept video di come funzionerebbe un gioco, mostrando gameplay, atmosfera, e stile visivo senza dover costruire un prototipo completo. Utile per pitch a publisher o per crowdfunding campaigns dove devi mostrare la visione del progetto.

- Contenuti per Non-Profit: Organizzazioni con budget limitati possono creare video emotivi per campagne di fundraising, awareness o advocacy. Una ONG ambientale potrebbe generare scene drammatiche dei cambiamenti climatici. Un'organizzazione umanitaria potrebbe visualizzare l'impatto del loro lavoro. WAN 2.5 democratizza la produzione video permettendo anche alle organizzazioni più piccole di competere con contenuti di qualità.

- Music Videos e Arte: Artisti possono creare music video completi o segmenti artistici sperimentali. La capacità di WAN 2.5 di generare stili visivi diversi lo rende perfetto per espressioni creative che vanno oltre il realismo puro.

- Corporate Communications: Video interni aziendali, annunci, training modules - tutto può essere generato rapidamente con WAN 2.5 su Pollo AI invece di organizzare costosi shooting video.

Particolarmente utile per aziende distribuite geograficamente dove radunare persone per riprese è logisticamente complesso.La chiave è creatività nel vedere opportunità. WAN 2.5 è uno strumento: il valore che genera dipende completamente da come lo usi e quali problemi risolvi con esso.

Il Futuro di WAN e della Generazione Video AI

Guardando WAN 2.5 e le sue capacità, è impossibile non riflettere su dove ci sta portando questa tecnologia. Siamo chiaramente solo all'inizio di una rivoluzione che trasformerà completamente il modo in cui creiamo e consumiamo contenuti video.La prossima frontiera ovvia è l'estensione della durata. Attualmente WAN 2.5 su Pollo AI genera clip di massimo 10 secondi. Ma è solo questione di tempo prima che vedremo modelli capaci di generare minuti interi, poi eventualmente video completi. Quando potremo generare un video di 5 minuti coerente con narrativa complessa, personaggi consistenti e archi emotivi sviluppati, il panorama della produzione video cambierà irrevocabilmente.Il supporto multi-lingue migliorerà drasticamente. Tra 6-12 mesi, aspettati che WAN 3.0 o successori gestiscano italiano, spagnolo, francese, tedesco e dozzine di altre lingue con la stessa naturalezza dell'inglese. Il lipsync sarà perfetto indipendentemente dalla lingua, rendendo questi tool veramente globali.Il controllo granulare aumenterà. Interfacce future permetteranno di specificare esattamente movimenti di camera, traiettorie di oggetti, timing preciso di azioni. Immagina un'interfaccia tipo timeline di editing video dove puoi definire keyframe, transizioni, cut - ma invece di editare footage esistente, stai dirigendo la generazione AI frame per frame.La personalizzazione estrema diventerà standard. Addestrerai modelli personalizzati sul tuo stile visivo, i tuoi personaggi, i tuoi ambienti preferiti. Ogni creator avrà essenzialmente il proprio "studio virtuale" capace di generare contenuti perfettamente coerenti con la sua brand identity. WAN 4.0 potrebbe includere feature dove carichi 10 foto del tuo viso e poi puoi generare video con te stesso come protagonista in qualsiasi scenario.L'integrazione con altri AI diventerà seamless. WAN 2.5 genera il video, un altro AI crea musica perfettamente sincronizzata, un terzo AI scrive sottotitoli ottimizzati, un quarto AI suggerisce i migliori moments per social snippets. L'intero pipeline di produzione video sarà automatizzato ma altamente personalizzabile.Le implicazioni etiche diventeranno sempre più pressanti. Quando chiunque può generare video fotorealistici di qualsiasi cosa o chiunque, come distingueremo realtà da finzione? Come proteggeremo contro deepfake malevoli? Come evolverà il concetto di copyright quando l'AI può creare "nello stile di" qualsiasi filmmaker? Queste domande non hanno ancora risposte chiare.Dal lato positivo, stiamo assistendo a una democratizzazione senza precedenti della produzione video. Storicamente, creare video di qualità richiedeva attrezzatura costosa, competenze tecniche specializzate, team di persone, e budget significativi. WAN 2.5 su Pollo AI mette capacità di produzione video Hollywood-level nelle mani di chiunque abbia un'idea e un laptop.Questo livellamento del campo da gioco significa che vedremo esplosione di creatività da voci precedentemente escluse. Lo studente di cinema in un paese in via di sviluppo senza accesso a attrezzatura può ora creare cortometraggi incredibili. L'artista visuale senza background tecnico può portare le sue visioni su schermo. L'educatore con budget zero può creare contenuti didattici rivali di produzioni costose.Ma significa anche saturazione. Quando tutti possono creare video professionali facilmente, il contenuto video diventerà commodity. La differenza tra successo e fallimento non sarà più nella capacità tecnica di produrre video, ma nell'unicità della visione creativa, nella qualità dello storytelling, e nell'autenticità della voce.WAN 2.5 rappresenta un momento di transizione. Tra 5 anni, guarderemo indietro a questo tool e ci stupiremo di quanto fosse primitivo, proprio come oggi guardiamo i primi smartphones e ci chiediamo come facevamo a usarli. Ma in questo momento, proprio ora, è all'avanguardia assoluta di ciò che è possibile con AI generativa video.

Vuoi vedere WAN 2.5 in azione con test pratici, confronti con altri generatori e tutorial dettagliati su come ottenere risultati perfetti? Iscriviti al canale YouTube di AI Universo dove trovi guide complete, trucchi di prompt engineering e tutti i segreti per diventare un professionista della generazione video con intelligenza artificiale!