EdgeTAM: il nuovo standard per il tracking AI on-device, firmato Facebook Research

Il futuro del video tracking è leggero, veloce e offline

Nel panorama dell’AI generativa e del computer vision, pochi problemi sono tanto importanti quanto il video tracking: riuscire a seguire un oggetto in movimento, in tempo reale, scena dopo scena.

E Facebook Research, ora sotto Meta AI, ha appena presentato una svolta epocale in questo campo: si chiama EdgeTAM, ed è il primo modello Track-Anything pensato specificamente per l’utilizzo on-device.In parole semplici? Con EdgeTAM puoi selezionare e tracciare qualsiasi oggetto o persona in un video direttamente da smartphone, tablet o edge device, senza bisogno di GPU cloud o server esterni.

Cosa rende EdgeTAM così rivoluzionario

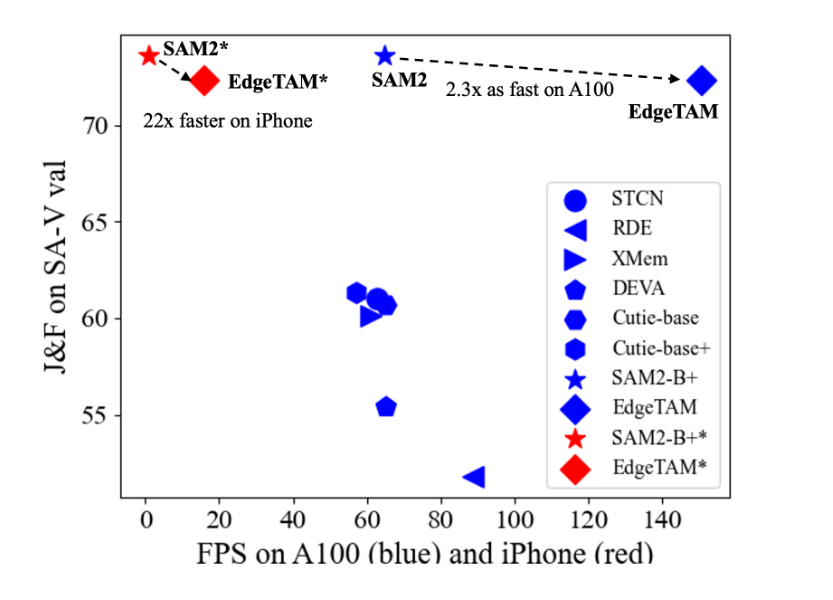

Il segreto di EdgeTAM è la sua architettura leggera ma estremamente efficiente, che riesce a mantenere alte prestazioni anche su dispositivi mobili. Secondo i benchmark rilasciati, EdgeTAM:

- Supporta video a 30 FPS in tempo reale

- Occupa meno di 150 MB in totale

- Funziona senza internet o server cloud

- Riconosce oggetti, persone, animali e persino parti anatomiche

- Non richiede training personalizzato o input complessi

È una vera rivoluzione per app mobili, droni, robotica di consumo, e anche per il montaggio video AI sul campo.

🎯 Scopri EdgeTAM e prova il primo sistema open-source capace di tracciare qualsiasi cosa in tempo reale su qualsiasi device, anche senza connessione.

Come funziona: pipeline e flusso operativo

Il cuore di EdgeTAM è una pipeline divisa in 3 fasi:

- Input dell’oggetto da tracciare: può essere selezionato con un box o un punto singolo nel frame iniziale

- Segmentazione e feature extraction: la rete CNN estrae i dati salienti e genera una mappa di tracking

- Tracking frame by frame: il sistema aggiorna la posizione e forma dell’oggetto ad ogni fotogramma

Il modello si comporta come una versione compatta dei grandi tracker AI (come SAM), ma ottimizzata per girare in locale.

Le potenzialità applicative: EdgeTAM ovunque

L’obiettivo di EdgeTAM non è solo la ricerca, ma l’adozione pratica in prodotti consumer e industriali. Le sue applicazioni includono:

- Editing video automatico su smartphone

- Filtri AR che seguono oggetti in tempo reale

- Robotica domestica che riconosce e insegue persone o oggetti

- App di sicurezza con tracciamento offline

- Realtà aumentata e virtuale, senza lag né connessione

La parte più interessante? Tutto il codice, modelli preaddestrati e test demo sono disponibili pubblicamente su GitHub, sotto licenza MIT.

✨ Vuoi altri tutorial e aggiornamenti su strumenti AI per immagini, video, musica e chatbot?

Visita il nostro canale YouTube AI Universo per guide pratiche ogni settimana!