Apple lancia FastVLM: l’AI visivo-linguistica ultraveloce pensata per iPhone

Cos’è FastVLM: il modello Apple per AI multimodale in tempo reale

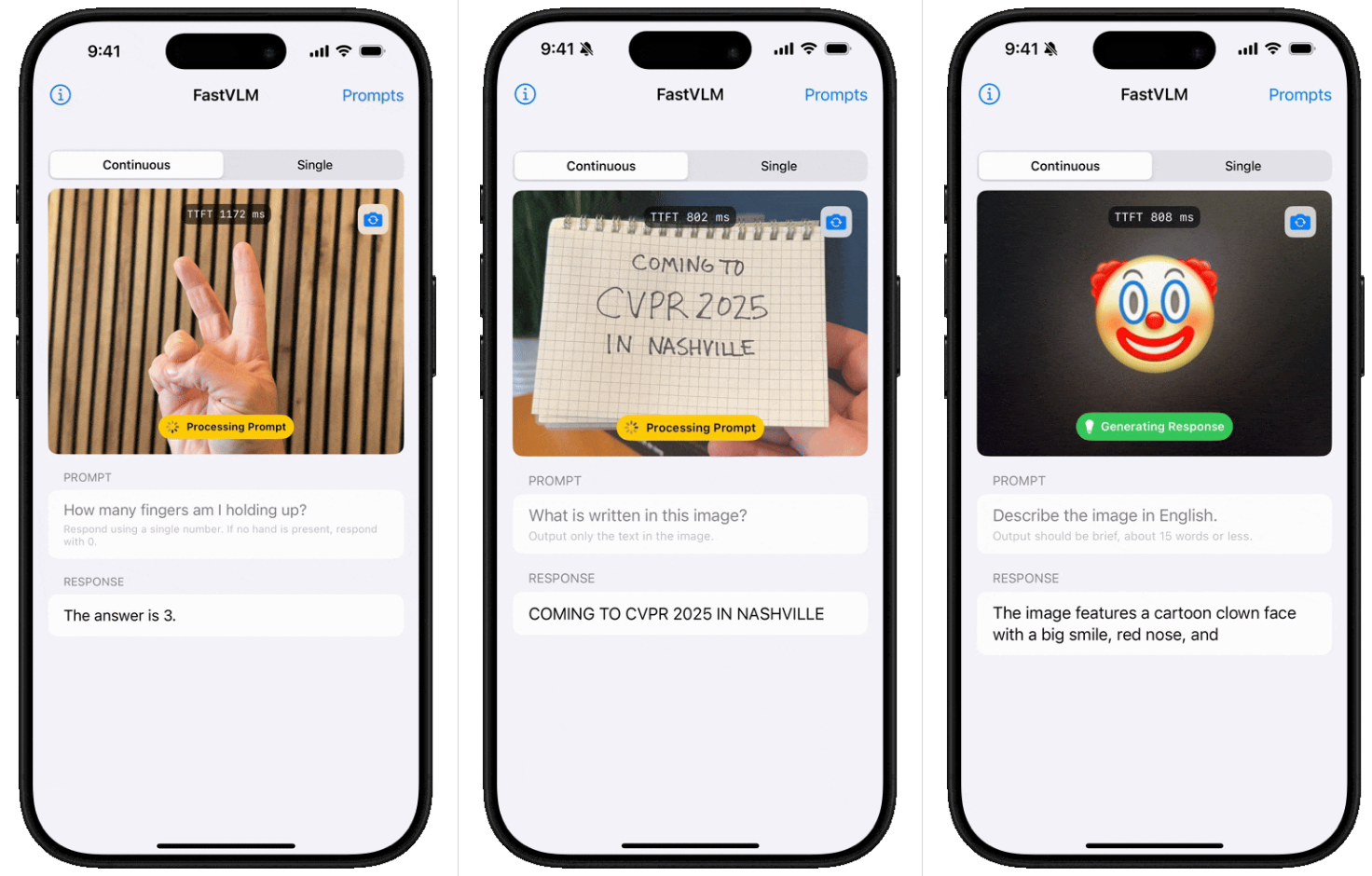

Apple ha ufficialmente presentato FastVLM, un nuovo modello visivo-linguistico (VLM) progettato per portare le funzionalità AI multimodali direttamente su dispositivi mobili, a partire da iPhone, iPad e Mac con chip M2 o A18. La novità più importante? Una velocità di codifica 85 volte superiore rispetto agli standard precedenti, senza rinunciare alla precisione.Alla base di questa rivoluzione troviamo FastViTHD, un encoder visuale ibrido sviluppato da Apple per elaborare immagini ad alta risoluzione con efficienza record. Grazie a tecniche come compressione gerarchica dei token e ottimizzazione hardware nativa, FastVLM permette operazioni di AI visiva avanzata a 60 FPS direttamente sul dispositivo.

Performance da record: confronto con i modelli top

FastVLM è disponibile in tre versioni: 0.5B, 1.5B e 7B parametri, pensate per coprire esigenze diverse — dalla leggerezza per mobile alla potenza di calcolo per usi professionali. Il modello più piccolo (0.5B):

- È 85 volte più veloce di LLaVA-OneVision-0.5B

- Ha un encoder visivo 3,4 volte più piccolo, con le stesse performance

- Riduce i token visivi da 1536 a 576 (-62,5% di calcolo)

Nei benchmark multimodali, i risultati sono notevoli:

- +8,4% su TextVQA

- +12,5% su DocVQA

- 82,1% di accuratezza su COCO Caption con il modello 7B

Il tutto con un tempo di risposta (TTFT) 7,9 volte più rapido rispetto ai modelli concorrenti. La combinazione di rapidità e accuratezza rende FastVLM uno dei modelli più promettenti del panorama mobile.

Ottimizzato per Apple: CoreML, INT8, basso consumo

Il cuore dell’innovazione è l’ottimizzazione per l’ecosistema Apple. FastVLM è stato integrato con:

- CoreML, per il deployment nativo su iOS e macOS

- Quantizzazione INT8, che riduce del 40% la memoria mantenendo il 98% di accuratezza

- Supporto a FP16, basso consumo energetico e inferenza fluida

Questo significa che l’AI non gira solo nel cloud, ma direttamente sul dispositivo, anche in scenari complessi come:

- Analisi mediche in mobilità (es. riconoscimento noduli polmonari)

- Controllo qualità in fabbrica

- Editing immagini avanzato in tempo reale

La demo su iPhone mostra risultati come:

- 93,7% di accuratezza nel rilevamento noduli

- -40% di falsi positivi nella produzione smartphone

Open source e visione strategica Apple

Apple ha rilasciato FastVLM come progetto open source sia su GitHub che su Hugging Face, usando come base il codice di LLaVA. Gli sviluppatori possono:

- Convertire modelli con la toolchain CoreML

- Effettuare fine-tuning guidati

- Integrare FastVLM in app real-time per mobile e desktop

Questo rappresenta un cambio di passo nella strategia AI di Apple, sempre più focalizzata su:

- Privacy-first (elaborazione locale)

- Ecosistema integrato (hardware + software)

- Esperienze AI in tempo reale per il grande pubblico

Nei prossimi mesi, FastVLM potrebbe diventare il cuore di:

- Assistenti vocali avanzati su iOS

- App fotografiche intelligenti

- Supporti visivi nelle app Messaggi, Note, Salute

Un salto netto verso una AI realmente mobile, sicura e performante.

Link ufficiale GitHub: https://github.com/apple/ml-fastvlm/