ReflectionFlow: l’ottimizzazione che rivoluziona la generazione text-to-image AI

Nell’universo in rapida evoluzione dell’intelligenza artificiale generativa, un nuovo framework si sta facendo notare: si chiama ReflectionFlow e promette di migliorare drasticamente la qualità e l’efficienza della generazione di immagini a partire da testo.Progettato per funzionare su modelli diffusion già esistenti (come Stable Diffusion, SDXL, Imagen e Kandinsky), ReflectionFlow introduce un approccio innovativo che ottimizza il processo di inferenza senza bisogno di modificare il modello base. Il risultato? Immagini più realistiche, meno rumorose e tempi di generazione ridotti.

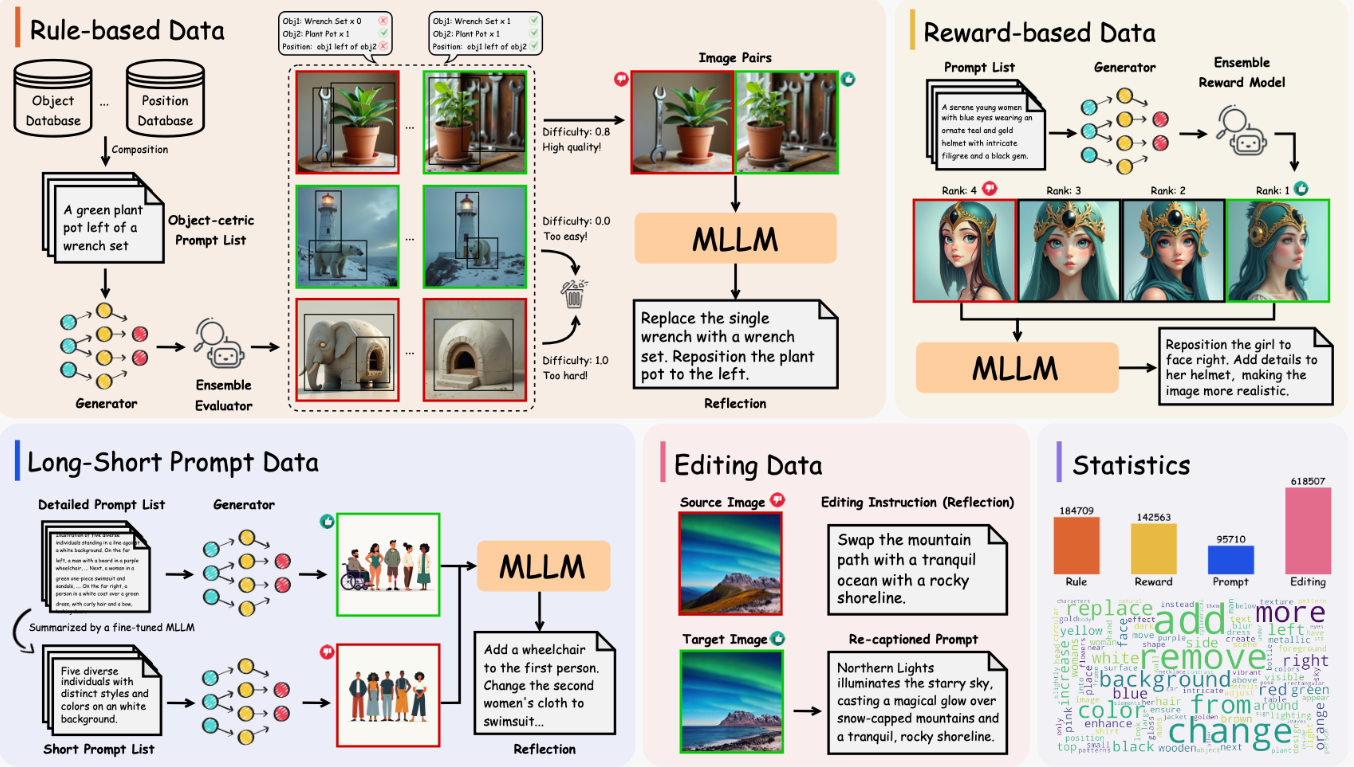

Come funziona ReflectionFlow?

ReflectionFlow si basa su una tecnica di ottimizzazione iterativa che guida il processo di denoising all’interno del modello diffusion. L’idea chiave è:

- effettuare una prima predizione rumorosa dell’immagine,

- correggerla riflettendo sulle informazioni testuali e visive,

- aggiornare il risultato passo dopo passo, mantenendo coerenza semantica.

Il sistema implementa una loss dinamica che valuta non solo la somiglianza visiva rispetto all'obiettivo, ma anche la fedeltà semantica rispetto al prompt testuale.Questo permette di:

- ridurre la quantità di rumore residuo nei dettagli più fini,

- migliorare la consistenza globale dell’immagine,

- aumentare la fedeltà visiva nei task di prompt complessi o astratti.

Perché ReflectionFlow è una svolta per i modelli diffusion

I modelli text-to-image tradizionali sono notoriamente sensibili:

- basta una parola in più o una struttura complessa nel prompt per ottenere risultati incoerenti,

- i dettagli fini spesso vanno persi durante le ultime fasi del denoising.

ReflectionFlow risolve questi problemi agendo durante l'inferenza e non in fase di training.

Questo significa che:

- è compatibile con qualsiasi modello diffusion pre-addestrato,

- può essere integrato facilmente in pipeline esistenti senza bisogno di retraining,

- migliora la qualità delle immagini senza aumentare il tempo di inferenza in modo significativo.

Inoltre, ReflectionFlow supporta inferenza parallela, rendendolo adatto anche per applicazioni ad alto volume come generazione di asset per videogiochi, pubblicità o creazione di dataset visivi.

Applicazioni pratiche e prospettive future

Con ReflectionFlow, le possibilità di utilizzo si ampliano enormemente:

- Content creation AI: generazione di immagini pubblicitarie, artistiche o editoriali di alta qualità.

- Gaming: creazione rapida di ambientazioni, personaggi e oggetti realistici.

- E-learning e editoria: produzione di immagini illustrative coerenti per manuali, corsi o piattaforme educative.

- Animazione e cinema: supporto nella creazione di storyboard, concept art e visual development.

Gli sviluppatori di ReflectionFlow prevedono ulteriori miglioramenti futuri, come l’adattamento dinamico ai prompt ambigui e l’integrazione in suite di creazione visiva commerciale.

🖼️ Vuoi vedere come migliorare la qualità delle immagini AI? Guarda il nostro speciale sul canale YouTube AI Universo per test pratici e tutorial passo passo!