Le Ultime Rivoluzionarie Novità nell'AI Video Generation: Waver 1.0, OmniHuman 1.5 e Molto Altro

Il mondo della generazione video AI sta vivendo una settimana di fuoco con annunci che ridefiniscono completamente gli standard del settore. ByteDance, la casa madre di TikTok, ha appena sganciato una bomba tecnologica con Waver 1.0, mentre contemporaneamente stupisce con OmniHuman 1.5. Ma non è tutto: Microsoft entra nel campo audio con il suo Copilot Voice, Tencent presenta Hunyuan Video Foley per l'audio cinematografico, e Alibaba sorprende con Wan-S2V. Preparatevi, perché quello che state per scoprire cambierà per sempre il vostro modo di vedere la creazione di contenuti digitali.

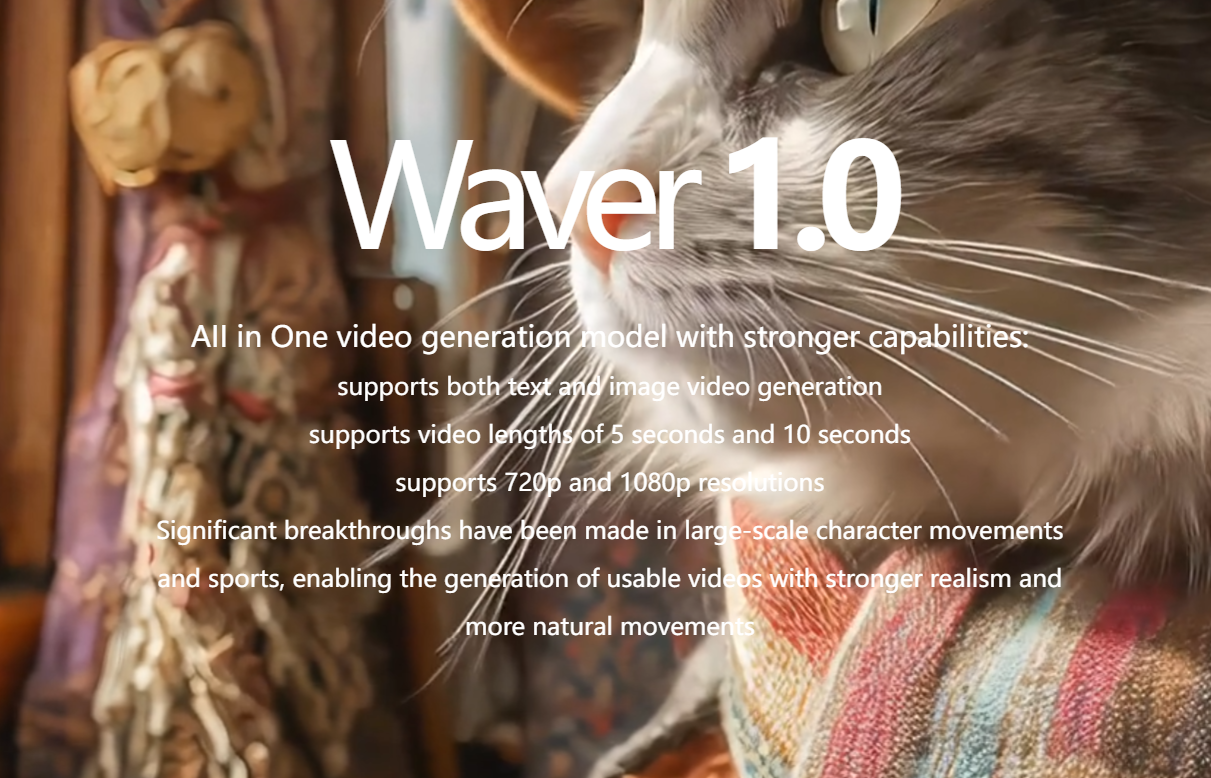

Waver 1.0: Il Nuovo Gigante della Generazione Video AI di ByteDance

ByteDance non si accontenta di dominare i social media con TikTok. Con il rilascio di Waver 1.0, l'azienda cinese dimostra di voler ridefinire completamente gli standard della generazione video tramite intelligenza artificiale. Questo nuovo modello generativo video rappresenta un salto quantico nella qualità e nel realismo delle clip generate artificialmente.La caratteristica più impressionante di Waver 1.0 è la sua capacità di generare video fino a 10 secondi con una qualità che spazia dal 720p al Full HD 1080p.

Ma non è la risoluzione a stupire quanto il frame rate: parliamo di circa 60 fps, una fluidità che rende i movimenti incredibilmente naturali e realistici. Pensate a quanto sia difficile per un'AI generare movimenti complessi come un tuffo in piscina o una nuotatrice che taglia l'acqua con precisione millimetrica. Waver 1.0 lo fa con una naturalezza disarmante.L'ottimizzazione per contenuti sportivi è dove questo generatore video AI brilla particolarmente. I movimenti atletici, tradizionalmente problematici per l'intelligenza artificiale generativa, vengono riprodotti con una precisione che lascia senza fiato. Una pattinatrice sul ghiaccio che esegue una pirouette, un giocatore di basket che dribbla tra gli avversari, un corridore in piena velocità: ogni movimento è fluido, coerente e privo di quegli artefatti che tipicamente tradiscono i video generati artificialmente.

Ma Waver 1.0 non si limita al realismo puro. Il sistema supporta nativamente la generazione multicamera, permettendo di creare sequenze narrative con cambi di inquadratura cinematografici. Immaginate di poter generare una scena con zoom drammatici, cambi di prospettiva e transizioni fluide, tutto mantenendo la coerenza visiva e narrativa. È come avere un regista virtuale che comprende le regole del linguaggio cinematografico.La versatilità stilistica è un altro punto di forza straordinario. Dal fotorealismo agli stili cartoon, dal 3D rendering agli effetti artistici più creativi, Waver 1.0 dimostra una flessibilità creativa che apre infinite possibilità per content creator e artisti digitali. Ogni stile mantiene quella qualità e fluidità che sono il marchio di fabbrica di questo nuovo strumento.

Per chi vuole provare Waver 1.0, attualmente l'accesso è disponibile tramite Discord per utenti non residenti nell'Unione Europea. Un limite temporaneo che sicuramente verrà superato nelle prossime settimane, vista l'enorme richiesta da parte della community creativa globale.

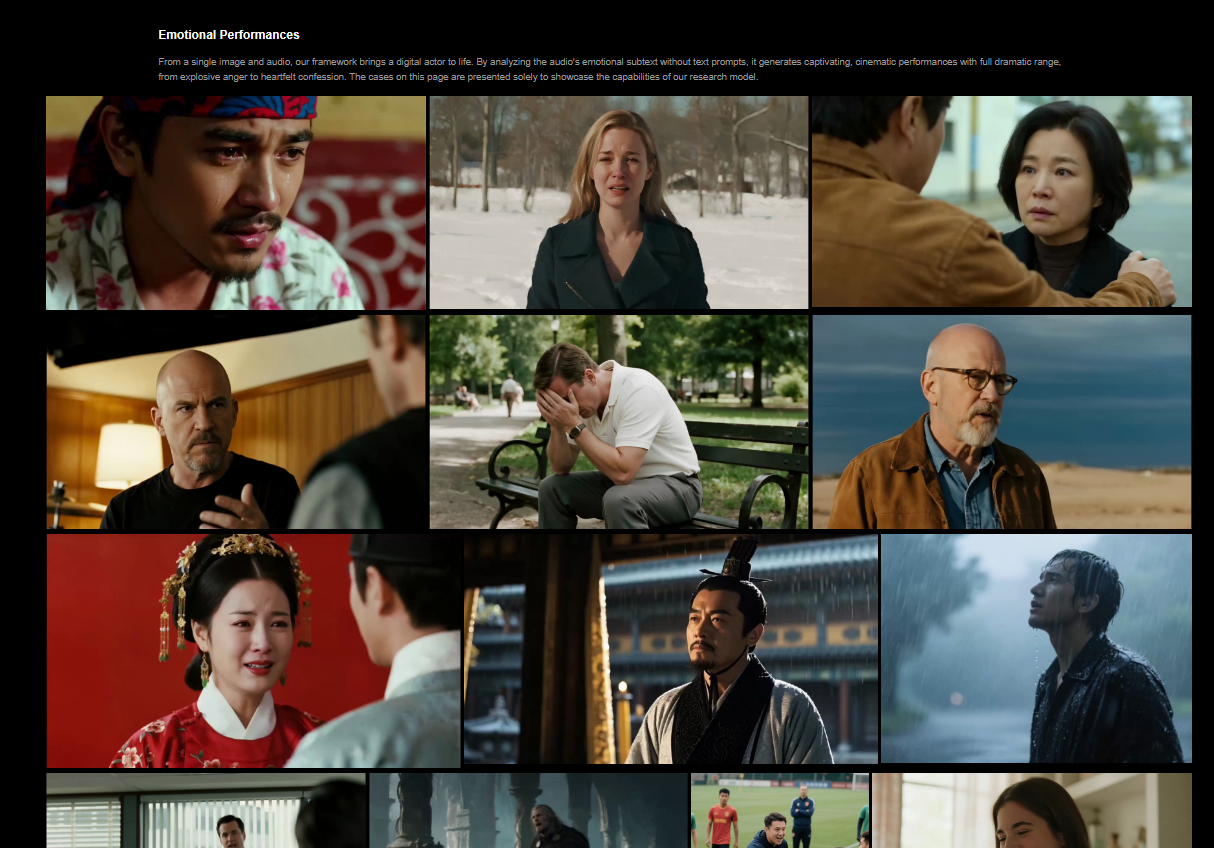

OmniHuman 1.5: L'Avatar AI che Recita Come un Attore Professionista

Se Waver 1.0 impressiona per la generazione video generale, OmniHuman 1.5 di ByteDance porta la creazione di avatar digitali umani a livelli mai visti prima. La versione 1.0 era già disponibile gratuitamente su piattaforme come DreamFace, ma questo aggiornamento rappresenta un salto evolutivo monumentale nell'espressività e nel realismo degli avatar AI.La prima cosa che colpisce di OmniHuman 1.5 è l'incredibile miglioramento nelle espressioni facciali e nella sincronizzazione labiale. Non parliamo più di semplice lip-sync meccanico, ma di vere e proprie performance emotive.

Gli avatar generati mostrano micro-espressioni, cambiano naturalmente l'intensità emotiva durante il discorso, e reagiscono al contenuto di ciò che stanno dicendo con una naturalezza che sfida la valle del perturbante.L'integrazione musicale rappresenta una delle innovazioni più impressionanti. Quando un avatar canta o parla su una base musicale, non si limita a muovere le labbra: l'intero corpo risponde al ritmo, le espressioni facciali si intensificano nei momenti emotivamente carichi della canzone, e la performance complessiva trasmette quella energia che normalmente associamo solo agli artisti umani.

Vuoi scoprire come AI Universo sta rivoluzionando il mondo dell'intelligenza artificiale? Visita il canale YouTube di AI Universo per tutorial esclusivi e anteprime delle ultime tecnologie AI che stanno cambiando il futuro della creatività digitale!

La capacità di gestire scene con multipli personaggi è un altro game-changer. OmniHuman 1.5 può orchestrare interazioni complesse tra diversi avatar, mantenendo la coerenza delle performance individuali mentre gestisce le dinamiche di gruppo. Pensate a una scena drammatica con due personaggi che discutono: ogni avatar mantiene la propria personalità espressiva, reagisce in modo credibile all'altro, e l'intera sequenza fluisce con naturalezza cinematografica.Le performance emotive sono dove OmniHuman 1.5 brilla veramente. Un avatar che piange non mostra solo lacrime digitali: l'intera struttura facciale si modifica, la voce si spezza nei momenti giusti, il respiro diventa affannoso. Un personaggio arrabbiato non si limita a gridare: la tensione muscolare è visibile, le vene del collo si tendono, gli occhi si stringono con intensità realistica.

Per i creatori di contenuti educativi, OmniHuman 1.5 apre possibilità straordinarie. Immaginate un Einstein digitale che spiega la relatività con gestualità professionale, muovendosi naturalmente davanti a una lavagna virtuale, girando la testa verso la classe immaginaria, modulando il tono per enfatizzare i concetti chiave. Non è più fantascienza: è realtà disponibile oggi.

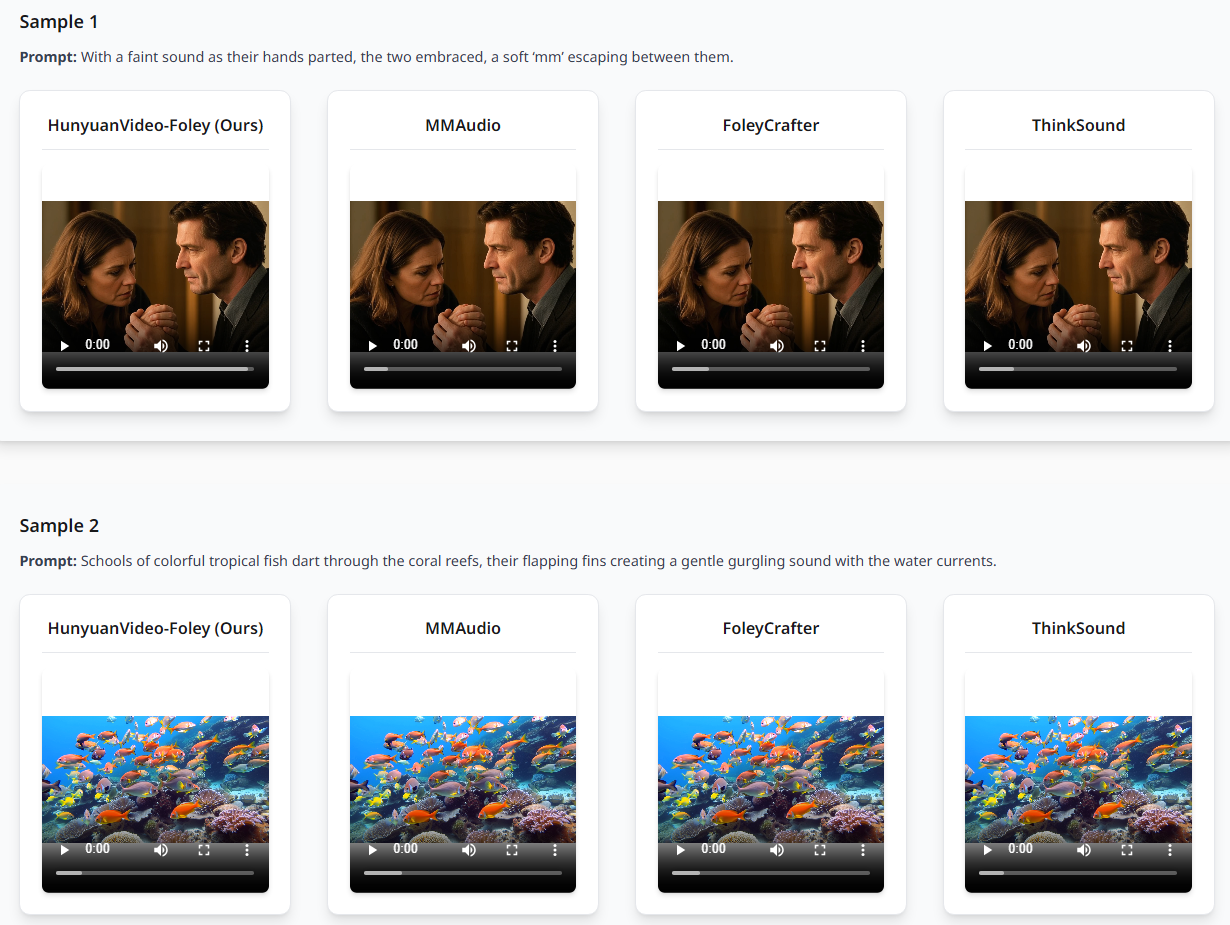

Hunyuan Video Foley: Il Suono Cinematografico Generato dall'AI di Tencent

Tencent entra nella competizione AI con Hunyuan Video Foley, un sistema di generazione audio che promette di rivoluzionare il modo in cui aggiungiamo suoni ai video. Non si tratta di semplici effetti sonori: parliamo di paesaggi sonori completi, cinematografici, che includono effetti ambientali, musica di sottofondo e tutto ciò che serve per trasformare un video muto in un'esperienza audiovisiva completa.La differenza rispetto a competitor come MM-Audio è immediatamente percepibile. Hunyuan Video Foley non si limita a generare il suono principale di una scena: costruisce un'intera atmosfera sonora.

Una scena subacquea non avrà solo il gorgoglio dell'acqua, ma anche quella sensazione ovattata tipica dell'immersione, magari con una delicata melodia ambientale che amplifica l'atmosfera onirica.L'intelligenza contestuale del sistema è straordinaria. Hunyuan Video Foley analizza non solo cosa sta succedendo nel video, ma anche il mood generale della scena. Un tramonto romantico riceverà automaticamente una colonna sonora appropriata, mentre una scena d'azione verrà accompagnata da suoni dinamici e musica adrenalinica. È come avere un sound designer professionista che comprende istintivamente le necessità narrative di ogni sequenza.

La qualità audio professionale è un altro punto di forza. Non stiamo parlando di suoni generici da libreria, ma di audio creato specificamente per ogni scena, con una qualità che regge il confronto con produzioni professionali. I suoni sono pieni, ricchi di dettagli, con una spazializzazione che crea un vero senso di profondità e presenza.

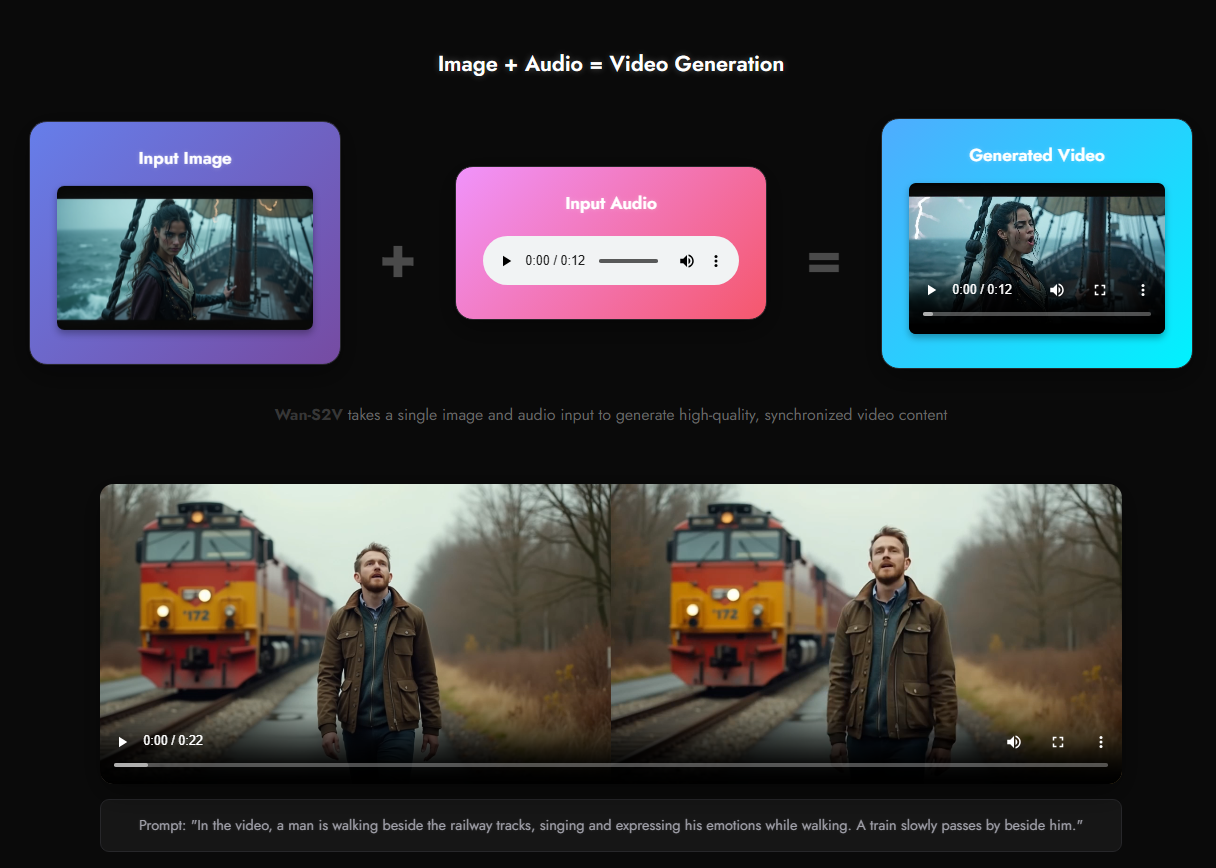

Wan-S2V di Alibaba: Quando l'Immagine Prende Vita con il Suono

Alibaba risponde alla concorrenza con Wan-S2V, un sistema che trasforma immagini statiche in video animati guidati dall'audio. La premessa è affascinante: carichi un'immagine e un file audio, e l'AI genera un video dove l'immagine si anima seguendo il ritmo e l'atmosfera del suono.La coerenza visiva è il vero punto di forza di Wan-S2V. L'immagine originale non viene stravolta ma delicatamente animata, mantenendo tutti gli elementi distintivi mentre aggiunge movimento e vita.

È perfetto per trasformare artwork statici in visualizzazioni dinamiche, o per creare video musicali partendo da semplici illustrazioni.L'interpretazione audio-visiva del sistema dimostra una comprensione sofisticata della relazione tra suono e movimento. Wan-S2V interpreta una musica energica producendo animazioni vivaci e dinamiche, mentre una melodia melanconica risulterà in movimenti più lenti e contemplativi. Non è una semplice sincronizzazione: è una vera interpretazione artistica del contenuto audio.

Le applicazioni creative sono infinite. Artisti digitali possono dare vita alle loro opere statiche, musicisti possono creare visualizzazioni uniche per le loro tracce, e content creator possono trasformare semplici immagini in contenuti video coinvolgenti con Wan-S2V. Il limite attuale nei frame per secondo è l'unico neo, ma la direzione tecnologica è chiaramente promettente.

USO di ByteDance: Il Cambio di Stile che Mantiene l'Anima

ByteDance non si ferma e presenta anche USO, un sistema di trasformazione stilistica delle immagini che mantiene una coerenza impressionante. Non si tratta del solito filtro Instagram: USO comprende la struttura profonda di un'immagine e la reinterpreta in stili completamente diversi mantenendo l'essenza del soggetto.La varietà di stili disponibili è vertiginosa. Dal fotorealismo al cartoon, dal 3D rendering allo schizzo artistico, ogni trasformazione mantiene non solo le caratteristiche fisiche del soggetto ma anche le sue espressioni e la sua personalità. Un sorriso rimane un sorriso, uno sguardo intenso mantiene la sua forza, indipendentemente dallo stile applicato con USO.L'interfaccia su Hugging Face rende USO accessibile a tutti.

Basta caricare un'immagine di riferimento, scegliere uno stile (o anche combinarne multipli), aggiungere un prompt descrittivo, e il sistema genera trasformazioni che mantengono una coerenza sorprendente. È completamente open source, il che significa che la community può contribuire al suo sviluppo e miglioramento.Per artisti e designer, USO rappresenta uno strumento di esplorazione creativa senza precedenti. Possono vedere le loro creazioni reinterpretate in stili diversi, esplorare nuove direzioni artistiche, o semplicemente generare variazioni stilistiche per diversi contesti e pubblici.

Microsoft Copilot Voice: L'Espressività Vocale che Emoziona

Microsoft entra nel campo della generazione vocale AI con una proposta che punta tutto sull'espressività emotiva. Copilot Voice, disponibile gratuitamente nella sezione Labs di Copilot, non è il solito text-to-speech: è un sistema che comprende e interpreta le emozioni del testo.

Non perdere le ultime novità rivoluzionarie nel mondo dell'AI! Iscriviti al canale YouTube di AI Universo dove troverai guide dettagliate, recensioni approfondite e tutorial pratici su tutti questi strumenti innovativi che stanno trasformando il panorama creativo digitale.

La gamma emotiva disponibile è impressionante. Non parliamo solo di "felice" o "triste", ma di sfumature complesse come "determinato", "curioso", "disgustato", con ogni emozione che modifica profondamente non solo il tono ma l'intera interpretazione vocale. Una stessa frase può trasformarsi completamente cambiando l'impostazione emotiva in Copilot Voice.Le voci disponibili sono straordinariamente naturali e diverse. Ogni voce ha la sua personalità distintiva, e quando combinata con le diverse emozioni, crea combinazioni uniche che possono adattarsi a qualsiasi contesto narrativo. Dal narratore calmo per meditazioni guidate al commentatore sportivo eccitato, ogni scenario trova la sua voce perfetta con Copilot Voice.

L'applicazione pratica per content creator è immediata. Podcast, audiolibri, video esplicativi, meditazioni guidate: ogni formato audio può beneficiare di questa tecnologia. Il limite attuale all'inglese è temporaneo, e quando arriverà il supporto italiano di Copilot Voice, sarà una rivoluzione per il content audio nel nostro paese.

Come Questi Strumenti Stanno Ridefinendo la Creatività Digitale

L'convergenza di tutte queste tecnologie sta creando un ecosistema creativo completamente nuovo. Non si tratta più di singoli strumenti isolati, ma di un arsenale completo che permette a chiunque di diventare un creatore di contenuti professionali senza anni di training tecnico.La democratizzazione della produzione video è forse l'impatto più significativo. Waver 1.0 permette di generare video di qualità cinematografica, OmniHuman 1.5 fornisce attori digitali convincenti, Hunyuan Video Foley aggiunge il suono professionale, e tutto questo è accessibile a costi frazione di una produzione tradizionale.

Per le aziende, queste tecnologie rappresentano un cambio di paradigma nel marketing e nella comunicazione. Possono creare contenuti personalizzati su scala, testare rapidamente diverse direzioni creative, e rispondere in tempo reale alle tendenze del mercato. Un'azienda può ora avere il suo portavoce digitale che parla perfettamente ogni lingua, mantiene sempre il tono del brand, ed è disponibile 24/7.Gli educatori trovano in questi strumenti alleati straordinari. Possono creare lezioni interattive con avatar che catturano l'attenzione degli studenti, generare contenuti educativi in diversi stili per diversi tipi di apprendimento, e rendere l'educazione più accessibile e coinvolgente che mai.

Il Futuro è Già Qui: Cosa Aspettarsi nei Prossimi Mesi

Le tendenze emergenti nel campo dell'AI generativa video sono chiare e entusiasmanti. Stiamo andando verso una completa integrazione di video, audio e interattività, dove la linea tra contenuto generato e reale diventerà sempre più sfumata.L'evoluzione della qualità è inarrestabile. Se oggi celebriamo i 60 fps di Waver 1.0, domani vedremo generazione in tempo reale a 120 fps in 4K. Le limitazioni attuali nella durata dei video (10 secondi) sono destinate a scomparire, aprendo la strada a cortometraggi e eventualmente lungometraggi completamente generati dall'AI.

L'integrazione multimodale sarà la norma. Immaginate di descrivere verbalmente una scena, e vedere l'AI generare simultaneamente video, audio, musica e dialoghi, tutto perfettamente sincronizzato e coerente. Non è fantascienza: con il ritmo attuale di sviluppo, potremmo vederlo entro la fine del 2025.La personalizzazione estrema diventerà standard. Ogni utente potrà avere il suo stile unico, i suoi avatar personalizzati, le sue preferenze audio, creando un'identità digitale creativa unica e riconoscibile. I brand potranno mantenere coerenza stilistica perfetta attraverso tutti i loro contenuti generati.

Considerazioni Pratiche per Content Creator e Professionisti

Per chi vuole iniziare a utilizzare questi strumenti oggi, il consiglio è di non aspettare. La curva di apprendimento è sorprendentemente dolce, e i benefici immediati. Iniziate con uno strumento alla volta, sperimentate Waver 1.0 per i video, OmniHuman 1.5 per gli avatar, e gradualmente integrate questi tool nel vostro workflow creativo.La strategia di contenuto deve evolversi per sfruttare queste nuove possibilità. Non si tratta più solo di "cosa" dire, ma di "come" dirlo in modi che prima erano impossibili o proibitivamente costosi. Un blog può diventare un video, un podcast può avere un presentatore visuale, un'immagine statica può prendere vita con Wan-S2V.

L'importanza della creatività umana non diminuisce, anzi aumenta. Questi strumenti sono moltiplicatori di creatività, non sostituti. La visione artistica, la comprensione del pubblico, la capacità di raccontare storie coinvolgenti: queste rimangono competenze umane insostituibili che questi strumenti amplificano.La considerazione etica è fondamentale. Con grande potere creativo viene grande responsabilità. È importante utilizzare questi strumenti in modo trasparente, rispettando i diritti d'autore, e mantenendo sempre chiara la distinzione tra contenuto generato e reale quando necessario.

L'Ecosistema in Rapida Evoluzione

La competizione tra giganti tech sta accelerando l'innovazione a ritmi mai visti. ByteDance con Waver 1.0 e OmniHuman 1.5, Microsoft con Copilot Voice, Tencent con Hunyuan Video Foley, Alibaba con Wan-S2V: ogni player porta innovazioni uniche che spingono l'intero settore forward. Questa competizione beneficia tutti noi utenti finali, che vediamo strumenti sempre più potenti e accessibili.L'open source gioca un ruolo cruciale.

Progetti come USO dimostrano che l'innovazione non è monopolio delle big tech. La community globale di sviluppatori e ricercatori contribuisce attivamente, democratizzando l'accesso a tecnologie all'avanguardia.Le implicazioni economiche sono profonde. Stiamo assistendo alla nascita di nuove professioni (AI prompt engineer, digital avatar designer), alla trasformazione di industrie intere (produzione video, doppiaggio, animazione), e alla creazione di opportunità economiche prima impensabili.

La convergenza tecnologica sta creando sinergie inaspettate. Quando combiniamo Waver 1.0 per la generazione video, OmniHuman 1.5 per gli avatar, Hunyuan Video Foley per l'audio, e USO per lo styling, otteniamo un sistema di produzione completo che rivaleggia con studi professionali da milioni di euro.

Non perdere le ultime novità rivoluzionarie nel mondo dell'AI! Iscriviti al canale YouTube di AI Universo dove troverai guide dettagliate, recensioni approfondite e tutorial pratici su tutti questi strumenti innovativi che stanno trasformando il panorama creativo digitale.